Лекция 24. Регрессионный анализ Функциональная

реклама

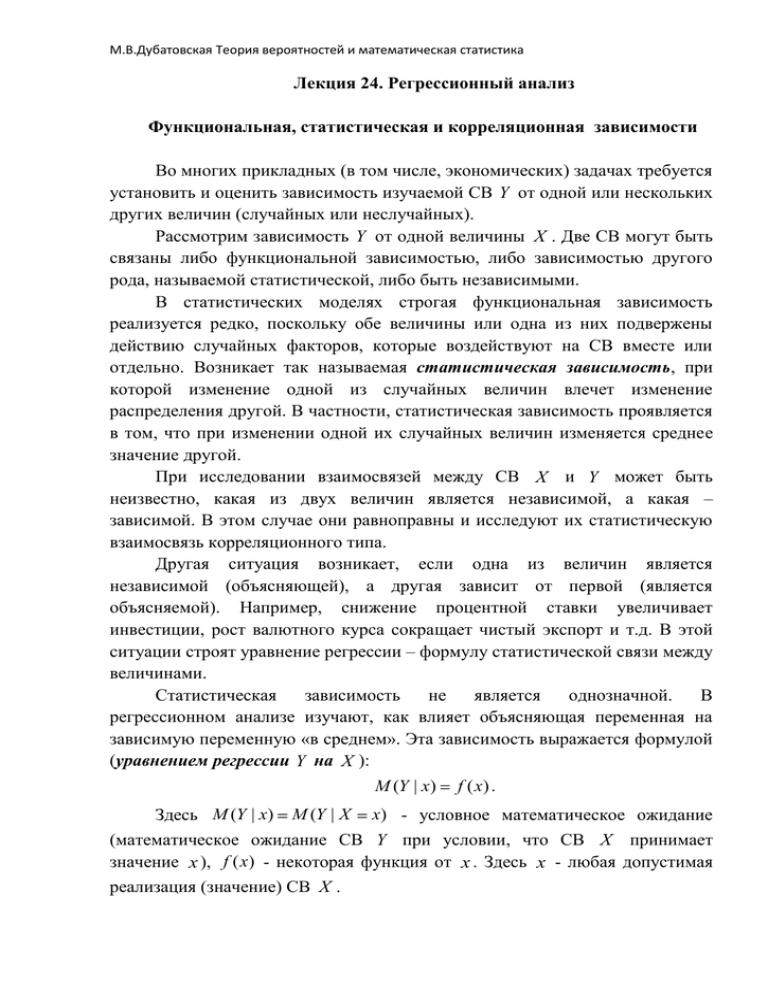

М.В.Дубатовская Теория вероятностей и математическая статистика Лекция 24. Регрессионный анализ Функциональная, статистическая и корреляционная зависимости Во многих прикладных (в том числе, экономических) задачах требуется установить и оценить зависимость изучаемой СВ Y от одной или нескольких других величин (случайных или неслучайных). Рассмотрим зависимость Y от одной величины X . Две СВ могут быть связаны либо функциональной зависимостью, либо зависимостью другого рода, называемой статистической, либо быть независимыми. В статистических моделях строгая функциональная зависимость реализуется редко, поскольку обе величины или одна из них подвержены действию случайных факторов, которые воздействуют на СВ вместе или отдельно. Возникает так называемая статистическая зависимость, при которой изменение одной из случайных величин влечет изменение распределения другой. В частности, статистическая зависимость проявляется в том, что при изменении одной их случайных величин изменяется среднее значение другой. При исследовании взаимосвязей между СВ X и Y может быть неизвестно, какая из двух величин является независимой, а какая – зависимой. В этом случае они равноправны и исследуют их статистическую взаимосвязь корреляционного типа. Другая ситуация возникает, если одна из величин является независимой (объясняющей), а другая зависит от первой (является объясняемой). Например, снижение процентной ставки увеличивает инвестиции, рост валютного курса сокращает чистый экспорт и т.д. В этой ситуации строят уравнение регрессии – формулу статистической связи между величинами. Статистическая зависимость не является однозначной. В регрессионном анализе изучают, как влияет объясняющая переменная на зависимую переменную «в среднем». Эта зависимость выражается формулой (уравнением регрессии Y на X ): M (Y | x) Здесь M (Y | x) M (Y | X f ( x) . x) - условное математическое ожидание (математическое ожидание СВ Y при условии, что СВ X принимает значение x ), f (x ) - некоторая функция от x . Здесь x - любая допустимая реализация (значение) СВ X . М.В.Дубатовская Теория вероятностей и математическая статистика Реальные значения зависимой переменной не всегда совпадают с условными математическими ожиданиями, поэтому имеет место соотношение: Y M (Y / x) , где - случайное слагаемое, выражающее отклонение от точной статистической зависимости (часто называемое ошибкой наблюдения или измерения, а также статистическим «шумом»). Исследование статистической зависимости Y от X проводится в предположении, что математическое ожидание равно 0. Оценка условного математического ожидания – условное выборочное среднее y x - также является функцией от x . Обозначая эту функцию f (x) , получим выборочное уравнением регрессии Y на X : yx f (x) . Функцию f (x) называют выборочной регрессией Y на X , а ее график – выборочной линией регрессии Y на X . yx Условным средним называют среднее арифметическое наблюдаемых значений СВ Y , соответствующих X x . Например, если при x1 2 СВ Y приняла значения y1 y3 5 , y2 6, 5 6 10 7. 3 При рассмотрении связи двух переменных речь идет о парной 10 , то условное среднее y x1 регрессии. Выбор вида формулы связи (функций f (x ) или f (x) ) называют спецификацией уравнения регрессии. Одна из самых простых – линейная связь. Парная линейная регрессия Рассмотрим случай парной регрессии в предположении, что функция f (x ) линейна. Тогда M (Y | x) где 0, 1 0 1x , - параметры линейной регрессии. На практике параметры линейной регрессии неизвестны и их оценки определяются по результатам наблюдений переменных Y и X . Пусть проведено n независимых наблюдений случайной величины Y при значениях объясняющей переменной x1 , x2 , ..., xn . При этом измерения величины Y дали следующие результаты: y1 , y2 , ..., yn . Так как эти значения М.В.Дубатовская Теория вероятностей и математическая статистика имеют разброс относительно линейной регрессии, то связь между переменными Y и x можно записать в виде линейной (по параметрам 0 , 1 ) регрессионной модели: Y где 1x 0 , - случайная ошибка наблюдений (так называемый «шум»), причем M ( ) 0 , D( ) 2 . Значение дисперсии ошибок 2 неизвестно, и оценка ее определяется по результатам наблюдений. Задача линейного регрессионного анализа состоит в том, чтобы по результатам наблюдений ( xi , yi ) , i 1, n : 1) Получить наилучшие точечные и интервальные оценки неизвестных параметров 0 , 1 и 2 линейной регрессионной модели. 2) Проверить статистические гипотезы о параметрах модели. 3) Проверить согласованность модели с результатами наблюдений (адекватность модели результатам наблюдений). В соответствии с моделью результаты наблюдений yi являются реализациями зависимой переменной Y , т.е. значениями случайных величин Yi 0 1x i, i 1, n . Задача линейного регрессионного анализа решается в предположении, что случайные ошибки наблюдений i и j не коррелированы, имеют математические ожидания, равные нулю, и одну и ту же дисперсию, равную 2 , т.е. M ( i) K i j 0, 0, i j , 2 , i j, i 1, n . При статистическом анализе регрессионной модели дополнительно предполагается, что случайные ошибки наблюдений i ( i 1, n ) имеют нормальное распределение, таким образом i ~ N (0, 2 ) ( i 1, n ). Заметим, что в силу сделанных предположений ошибки наблюдений являются независимыми случайными величинами. Для нахождения точечных оценок параметров модели по результатам наблюдений используется метод наименьших квадратов (МНК). По этому методу выбирают такие оценки параметров 0 , 1 , которые минимизируют сумму квадратов отклонений наблюдаемых значений случайных величин Yi от их математических ожиданий, т.е. М.В.Дубатовская Теория вероятностей и математическая статистика n Q( 0, 1) ( yi ( 1 xi )) 0 2 min . i 1 МНК-оценки параметров линейной регрессии имеют вид распространяются на все наблюдаемые пары значений ( xi , yi ) ): ˆ ( xi 1 x)( yi x) 2 ( xi ˆ y) y ˆ x, 1 n xy x n x2 ( 0 (суммы , или ˆ ˆ 1 x2 0 y x2 n y x) 2 x , xy x) 2 ( . Оценки параметров линейной регрессии, вычисленные по методу наименьших квадратов, при указанных выше условиях имеют следующие свойства: 1) Они являются линейными функциями результатов наблюдений yi , ( , j 0,1 . i 1, n ) и несмещенными оценками параметров, т.е. M ( ˆ ) j j 2) Они имеют минимальные дисперсии в классе несмещенных оценок, являющихся линейными функциями результатов наблюдений, и в этом смысле наилучшими несмещенными оценками. 3) МНК-оценки совпадают с оценками, вычисленными по методу максимального правдоподобия. Функция ˆ x y f ( x) ˆ x 0 1 определяет выборочную (эмпирическую) регрессию Y на X . Она является оценкой теоретической регрессии по результатам наблюдений. Разности между наблюдаемыми значениями yi переменной Y при x xi и расчетными ˆ x называются остатками и обозначаются ei : значениями ~ y ˆ i 0 1 i ei yi ~y , ( i 1, n ). i Выборочное уравнение регрессии записывают еще в виде: ˆ y x. x Коэффициент на X . xy 0 xy называют выборочным коэффициентом регрессии Y М.В.Дубатовская Теория вероятностей и математическая статистика x2 , то x nx , y ny , x 2 n x 2 , и n n n получаем следующие формулы для вычисления этого коэффициента: Поскольку x x ,y xy y , x2 n xy n 2 x x ( y x) xy n x y . n~ 2 2 x Здесь ~ x , ~ y - выборочные с.к.о. ~ Умножим обе части равенства на ~ x . Получим xy y ~ x ~ y xy n x y . n~ ~ x y Обозначим rВ ~ x ~ xy y и назовем rВ выборочным коэффициентом корреляции. Таким образом, xy n x y . n~ ~ rВ x Выразим из последнего равенства y xy : ~ xy rВ ~ y x тогда уравнение прямой регрессии Y на X имеет вид: ~ y y x y rВ ~ ( x x ) . x Аналогично для регрессии X на Y получаем уравнение: ~ x y x rВ ~ x ( y y ) . y Замечание 1. Поскольку зависимость X и Y не является функциональной, то регрессии Y на X и X на Y не являются обратными функциями. Замечание 2. Выборочный коэффициент корреляции является оценкой коэффициента корреляции r M ( XY ) M ( X ) M (Y ) ~ ~ x y М.В.Дубатовская Теория вероятностей и математическая статистика (можно показать это методом моментов). Метод проверки гипотезы о значимости выборочного коэффициента корреляции мы рассматривали выше. Заметим, что rВ2 xy и yx , т.к. yx xy yx ~ rВ ~ x , rВ ~ xy xy yx . Знак rВ совпадает со знаком y rВ ~ . x y Квадрат коэффициента корреляции rВ2 называют коэффициентом детерминации. Он характеризует долю дисперсии результативного признака Y , объясняемую регрессией, в общей дисперсии результативного признака. Соответственно, 1 rВ2 характеризует долю дисперсии результативного признака Y , вызванную влиянием остальных, не учтенных в модели факторов. Сгруппированные данные. Корреляционные таблицы При большом числе наблюдений одно и то же значение x может встретиться n x раз, одно и то же значение y - n y раз. Одна и та же пара чисел ( x, y ) может наблюдаться n xy раз. Поэтому данные наблюдений группируют, т.е. подсчитывают частоты nx , ny , nxy . Сгруппированные данные записывают в виде таблицы, которую называют корреляционной. Например, Y X 0,4 0,6 0,8 nx 10 20 30 40 ny 5 3 8 2 19 21 7 6 13 14 4 18 26 12 22 n 60 В случае сгруппированных данных параметры регрессии вычисляются по формулам, аналогичным формулам для несгруппированных данных. Выборочный коэффициент регрессии Y на X рассчитывают по формуле nxy xy n x y xy n( x 2 ( x) 2 ) nxy xy n x y , n~ 2 x а выборочный коэффициент корреляции – по формуле М.В.Дубатовская Теория вероятностей и математическая статистика rВ nxy xy n x y . n~ ~ x y Уравнение прямой регрессии Y на X так же, как и в случае несгруппированных данных, имеет вид: ~ y y x y rВ ~ ( x x ) . x Аналогично для регрессии X на Y уравнение имеет вид: ~ x y x rВ ~ x ( y y ) . y Корреляционное поле. Точки корреляционного поля строятся по наблюдаемым данным. В случае несгруппированных данных в системе координат строят точки с координатами ( xi , yi ) , соответствующие парам наблюдаемых значений случайных переменных X и Y . В случае сгруппированных данных точки корреляционного поля имеют координаты ( xi , y xi ) . Построенное корреляционное поле помогает произвести спецификацию уравнения регрессии (выбор вида зависимости). y 0 x Рис 7.1. Корреляционное поле и линия регрессии М.В.Дубатовская Теория вероятностей и математическая статистика Анализ статистической значимости коэффициентов линейной регрессии Рассчитанные коэффициенты регрессии являются значениями случайных величин. При выполнении предпосылок относительно распределения i их математические ожидания равны 0 , 1 . При этом оценки тем надежнее, чем меньше их разброс вокруг 0 и 1, т.е. дисперсия. Надежность получаемых оценок параметров ˆ 0 , ˆ 1 зависит от дисперсии случайных отклонений i, но поскольку по данным выборки эти отклонения (и, соответственно, их дисперсии) оценены быть не могут, то при анализе надежности коэффициентов регрессии их заменяют на отклонение yi от ˆ x. линии регрессии ˆ 0 1 Непосредственными вычислениями получаем, что D( 1 ) S2 , ( xi x ) 2 S 21 i xi 2 S2 D( 0 ) S 20 i n ( xi x )2 , i ei 2 где S 2 - мера разброса зависимой переменной вокруг линии n 2 дисперсии (необъясненная дисперсия). Коэффициент 1 есть мера наклона линии регрессии. Очевидно, чем i больше разброс значений y вокруг линии регрессии, тем больше в среднем ошибка в определении наклона линии регрессии. Если такого разброса нет совсем, то прямая определяется однозначно и ошибки в расчете коэффициентов регрессии отсутствуют. Дисперсия D ( 0 ) свободного члена уравнения пропорциональна D ( 1 ) xi 2 и равна D( и, тем самым, также соответствует приведенным n выше пояснениям. Кроме того, дисперсия тем больше, чем больше средняя 0) D( 1 ) i величина xi 2 . При больших значениях x даже небольшое изменение наклона регрессионной прямой может вызвать большое изменение оценки свободного члена. М.В.Дубатовская Теория вероятностей и математическая статистика Формально значимость оцененного коэффициента регрессии быть проверена с помощью анализа его отношения к своему с.к.о. 1 может D( 1 ) . Эта величина при выполнении исходных предпосылок модели имеет распределение Стьюдента с n 2 степенями свободы ( n - число наблюдений): T 1 D( 1 ) . Проверяется нулевая гипотеза о равенстве ее нулю. Проверка значимости коэффициента парной линейной регрессии эквивалентна проверке значимости коэффициента корреляции x и y .