общий случай

advertisement

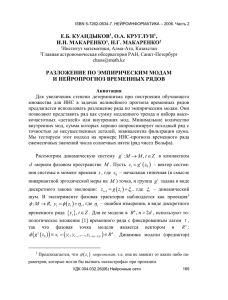

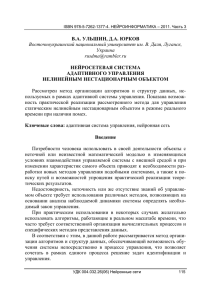

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 Я.М. КАРАНДАШЕВ, Б.В. КРЫЖАНОВСКИЙ, Л.Б. ЛИТИНСКИЙ Научно-исследовательский институт системных исследований РАН, Москва ya_rad_wsem@mail.ru, kryzhanov@mail.ru, litin@mail.ru ОБОБЩЕННАЯ МОДЕЛЬ ХОПФИЛДА И СТАТФИЗИЧЕСКИЙ ПОДХОД: ОБЩИЙ СЛУЧАЙ Для модели Хопфилда с квази-Хеббовской матрицей связи решается основное уравнение статфизического подхода при произвольном распределении весовых множителей. Показано, что память системы всегда ограничена, однако «катастрофы памяти», характерной для стандартной модели Хопфилда, не происходит. Детально исследован случай весовых множителей в виде убывающей геометрической последовательности. Емкость памяти при этом пропорциональна размерности задачи. Ключевые слова: сеть Хопфилда, матрица связи Хебба, вес паттерна, «катастрофа памяти» 1. Введение В стандартной модели Хопфилда [1] паттерны, участвующие в образовании Хеббовской матрицы связи, случайны и независимы. Симметрия выражения для матричных элементов делает паттерны полностью равноправными: что справедливо для одного из них, то же будет выполняться и для любого другого. В результате происходит так называемая «катастрофа памяти» – сеть работает как ассоциативная память только до тех пор, пока число паттернов M не превзойдет некоторого критического значения: M c 0,138 N . Если M превзойдет M c , все паттерны перестанут сетью распознаваться: память системы полностью разрушится. Модель Хопфилда является моделью человеческой памяти (пусть и на очень грубом, качественном уровне). С этой точки зрения катастрофа памяти полностью противоречит здравому смыслу. Очевидно, что эволюция человеческой памяти происходит путем ее частичного обновления, а не путем полного разрушения накопленных сведений. Данное противоречие между математической моделью и моделируемой реальностью было отмечено уже на ранней стадии исследований [2]– [4]. Изложение попыток усовершенствовать стандартную модель Хопфилда можно найти в [5]. Наш подход состоит в том, чтобы снабдить патУДК 004.032.26(06) Нейронные сети 182 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 терны индивидуальными весовыми множителями (весами). Расчет делается на то, чтобы с помощью различий в весах индивидуализировать условия распознавания отдельных паттернов, и тем устранить «катастрофу памяти». В предыдущей работе [6] в рамках статфизического подхода было получено основное уравнение для модели Хопфилда с квази-Хеббовской матрицей связи. (Последняя отличается от матрицы Хебба тем, что паттерны снабжаются индивидуальными весами.) Уравнение удалось решить для случая, когда только один вес отличается от остальных весов, тождественно равных друг другу. Оказалось, что в этой ситуации для паттернов с многократно вырожденным весом имеет место аналог «катастрофы памяти»: все паттерны одновременно либо распознаются сетью, либо не распознаются. Теоретические результаты были подтверждены компьютерным экспериментом. В настоящей работе излагаются результаты исследования общего случая, когда все веса различны. Подробно рассмотрен случай весов в виде убывающей геометрической прогрессии. Полученные теоретические результаты сравниваются с компьютерным экспериментом. Мы используем обозначения и уравнения, введенные в работе [6]. 2. Различные весовые множители Выражение для матрицы связи имеет вид M J r x x , + 1 где N-мерная вектор-строка x ( x1 , x2 ,..., xN ) (1) с бинарными координа- тами есть -й паттерн , а веса r положительны и упорядочены по убыванию: r1 r2 ... rM .... 0. С помощью введенных в [6] вспомогательных функций ( y) 2 y2 e и ( y) erf ( y) y2 e 2y (2) для данной системы можно записать основное уравнение статфизического подхода – см. выражение (3) в [6]. Преобразуем это уравнение, сократив левую и правую части на число паттернов M, одновременно положив это число бесконечно большим ( M ): УДК 004.032.26(06) Нейронные сети 183 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 N f(k ) ( y) , k (3) где функции f( k ) выражаются через функции , и веса r : 2 t( k ) r (4) f( k ) ( y ) , t( k ) , 1, 2,..., k 1, k 1, k 2,... . (k ) rk ( t ) ( y) – возрастающая функция, с минимальным значением (0) 1 . Уравнение (3) связывает размерность задачи N и номер паттерна k . Отыскав решение этого уравнения y , можно вычислить перекрытие k-го паттерна с ближайшей к нему неподвижной точкой: mk erf y . (5) Если mk 1 , k-й паттерн сетью распознается; если же mk 1 , то не распознается. Уравнение (3) позволяет отыскать максимальный номер паттерна, который еще распознается сетью. Покажем это. Величины t(k ) упорядочены по убыванию. Первые k 1 из них превосходят 1, а остальные меньше 1: t1( k ) t2( k ) ... tk( k)1 1 tk( k)1 tk( k)2 .... (6) Правая часть уравнения (3) есть результат суммирования по набору функций f( k ) ( y) k . Рассмотрим, как ведут себя функции f(k ) ( y) (4). При y знаменатель ( t( k ) ) функции f(k ) ( y) стремится к 0, оставаясь положительным – значит, на бесконечности любая функция f(k ) ( y) неограниченно возрастает. Следовательно, неограниченно растет на бесконечности и правая часть уравнения (3). Далее, поведение функции f(k ) ( y) в области конечных значений y зависит от того, больше или меньше 1 константа t(k ) в знаменателе. Если t(k ) 1 , функция f(k ) ( y) непрерывна и ограничена. Если же t(k ) 1 , функция f(k ) ( y) имеет точку сингулярности: в этом случае знаменатель функции f(k ) ( y) обращается в ноль при некотором значении аргумента y(k ) УДК 004.032.26(06) Нейронные сети 184 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 y( k ) t( k ) y( k ) 1 t( k ) ; через 1 здесь обозначено отображение, обратное к . Мы видим, что при t(k ) 1 функция f(k ) ( y) терпит разрыв второго рода в точке y(k ) . Поскольку первые k 1 величин t(k ) в ряду (6) больше 1, понятно, что положительная функция в правой части уравнения (3) имеет разрывы второго рода в точках yk( k)1 yk( k)2 ... y1( k ) , а на бесконечности неограниченно возрастает. Преобразуем уравнение (3), перейдя к обратным величинам: 1 1 Fk ( y ) , где Fk ( y ) f( k ) ( y ) . N k (7) Очевидно, что неотрицательная функция Fk ( y) в правой части уравнения (7) обращается в ноль в точках yk( k)1 < yk( k)2 <…< y1(k ) , а на бесконечности стремится к нулю (на рис. 1,a показано типичное поведение функции Fk ( y) ). Правее самого правого нуля y1(k ) , там, где выполняется неравенство ( y) t1(k ) , функция Fk ( y) сначала возрастает, а затем, пройдя через максимум, начинает монотонно убывать. Обозначим самую правую точку максимума Fk ( y) через yc( k ) . Этим значением и определяются критические характеристики, связанные с распознаванием k-го паттерна. Вообще говоря, уравнение (7) имеет множество решений. Их число равно числу пересечений с функцией Fk ( y) прямой линии, параллельной оси абсцисс и проведенной на высоте 1 N . Нас, однако, интересует только то пересечение, которое превосходит точку самого правого максимума yc( k ) – именно этому решению уравнения (7) отвечает минимум свободной энергии (см. раздел II в [6]). Остальными решениями уравнения (7) можно пренебречь. На рис. 1,a показано, как ведет себя функция Fk ( y) для паттерна с номером k 5 , когда веса имеют вид r 1/ . Функция F5 ( y) обращается в ноль в точках y4(5) < y3(5) < y2(5) < y1(5) . Для значений аргумента y, превосходящих наибольшую из этих точек y1(5) , функция F5 ( y) сначала возрастает до максимума в точке yc(5) , а затем монотонно стремится к нулю. Пунктирная прямая, параллельная оси абсцисс, проведена на высоте 0,001. УДК 004.032.26(06) Нейронные сети 185 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 Приравняв этому значению левую часть уравнения (7), получим: N 1000 . Иными словами, для матрицы такой размерности (с весами r 1/ ) в окрестности 5-го паттерна непременно существует неподвижная точка, и перекрытие с паттерном близко к 1: мы видим, что y0 3,5 , а перекрытие вычисляется по формуле m5 erf ( y0 ) . При постепенном уменьшении размерности N прямая линия будет подниматься вверх, а решение y0 уравнения (7) будет уменьшаться. Так будет продолжаться до тех пор, пока y0 не достигнет критического значения yc(5) . Этим и определится минимальная размерность N min , при которой в окрестности 5-го паттерна существует неподвижная точка. Для меньших размерностей, N N min , неподвижной точки в окрестности 5-го паттерна не существует. На языке нейронных сетей это означает, что при N N min 5-й паттерн сетью не будет распознаваться. Точка yc( k ) играет ту же роль, что и критическая точка yc в стандартной модели Хопфилда. УДК 004.032.26(06) Нейронные сети 186 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 a b Рис. 1. Поведение функции Fk ( y) из правой части уравнения (7) для весов r 1 / . На левом рисунке k 5 , y0 – решение уравнения для 1 N 0.001 , yc(5) – критическое значение аргумента (см. текст). На правом рисунке k 3, 6, 9. С ростом k точка yc( k ) растет, а величина максимума Fk ( yc( k ) ) падает В приведенном рассуждении фиксировался номер паттерна k и уменьшали размерность N . Естественнее действовать наоборот: зафиксировать размерность N и, постепенно наращивая k , искать его максимальное значение, для которого уравнение (7) имеет решение в интересующей нас области. На рис. 1b показано поведение кривых Fk ( y) для различных значений k . С ростом k критическая точка yc( k ) увеличивается, а величина максимума Fk ( yc( k ) ) неуклонно понижается. Ясно, что сущеУДК 004.032.26(06) Нейронные сети 187 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 ствует максимальное значение k , для которого уравнение (7) имеет решение. Обозначим его через kmax kmax ( N ) . Для данной размерности N паттерн с номером kmax является последним, в окрестности которого существует неподвижная точка. Для k kmax уравнение (7) тем более имеет решение в области y yc( k ) – эти паттерны тоже будут распознаваться сетью. Напротив, для k kmax уравнение (7) не имеет решения в области y yc( k ) . Несмотря на то, что такие паттерны участвуют в образовании квази-Хеббовской матрицы, распознаваться они не будут. Таким образом, память системы оказывается ограниченной, однако «катастрофы памяти» не происходит. Все cказанное справедливо для произвольных весов r . В следующем разделе рассмотрим конкретное распределение весов, для которого удается продвинуться в аналитическом исследовании. 3. Веса в виде геометрической прогрессии Разберем подробно случай весов вида r q , где q (0,1) . Это распределение весов обсуждалось в [5]. Начальное значение индекса суммирования естественно положить равным 0 и принять, что первый вес равен 1: r0 1 . Тогда имеем 2 q q 2 k , где sk q ( y ) . (q k q ) 2 sk q Уравнение (3) принимает вид: f( k ) ( y ) ~ 2 q (8) N s q , 0 k 0 k k найдем его решение при больших значениях аргумента, в области, где выполняется неравенство sk q k ( y ) 1 . Заменяя в правой части (8) суммирование интегрированием, и переходя в левой и правой частях уравнения к обратным величинам, получаем аналог уравнения (7): f( k ) ( y ) 1 2 УДК 004.032.26(06) Нейронные сети 188 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 s 1 1 ln k s s 1 1 , где k ( y ) k k , sk q k 1 . N ( 1) 2 k ( y ) 1 ln q (9) Численно решая уравнение (9), можно найти kmax – наибольший номер паттерна, который распознается сетью – он будет зависеть от N и q : 2 ( 1) 2 (10) kmax kmax ( N , q) . Нас интересует такое значение q , которому отвечает максимум kmax : k ( N ) max kmax ( N , q) . (11) q Ясно, что оптимальное в этом смысле значение q должно существовать – обозначим его через qm : qm qm ( N ) . На левой панели рис. 2 для трех размерностей N показана зависимость от q отношения kmax ( N , q) / N . У всех кривых имеется отчетливо выраженный максимум. Для разных N максимум достигается при различных значениях qm , но величина максимума одинакова: lim k ( N ) / N 0.05 . N (12) Иначе говоря, максимальное число паттернов, которое способна хранить такая сеть, пропорционально размерности задачи N: M c 0,05 N . Приведем оптимальные значения qm ( N ) : qm 0,992; 0,9992 и 0,99992 для N =1000, 10000 и 100000 соответственно. Если значение параметра q будет больше, чем оптимальное значение qm , то число распознаваемых паттернов станет уменьшаться. Критическое значение qc , начиная с которого, не будет распознаваться уже ни один паттерн – q станет таким большим, что ситуация приблизится к стандартной модели Хопифлда. Чем больше N , тем qc ближе к 1. Для тех же размерностей: qc 0,997; 0,9997, 0,99997 соответственно. На правой панели рис. 2 для паттерна с номером kmax показана зависимость от q перекрытия с неподвижной точкой. Отметим, что в точке «срыва» решения, qc , когда паттерны перестают распознаваться, величина перекрытия приблизительно одинакова: mc 0,933 . УДК 004.032.26(06) Нейронные сети 189 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 m kmax / N q q Рис. 2. Для трех значений N показаны: слева – зависимость от q отношения kmax / N ; справа – синхронные значения перекрытия kmax – паттерна с ближайшим минимумом. Сплошная линия – N = 1000, штриховая линия – N = 10000, точечная линия – N = 100000 (см. текст). Точке максимума на левой панели отвечает k ( N ) / N – см. (11) Эти результаты получены численным решением уравнения (9). В области больших значений y ( y 2 ) упростим правую часть уравнения (9): 1 2q 2 k | ln q | , где g erf y / 2 y 1/ 2 y . Это позволяет выпи g2 N 1 2q 2 k | ln q | сать явное выражение для k : k ln[2( Ng 2 1) | ln q |] , 2 | ln q | (13) Это выражение можно максимизировать по q : величина k принимает максимальное значение: k0 ( Ng 2 1) / e Ng 2 / e N / 2ey 2 при 1)) . Потребуем выполнения условий идеального распознавания, когда паттерн и неподвижная точка отличаются меньше, чем на 1 бит: m erf ( y) 1 1/ N . Используя известное приближение для функции q0 1 e / (2( Ng 2 erf ( y) , получаем, что должно выполняться: y ln( N / 4) . Тогда имеем: УДК 004.032.26(06) Нейронные сети 190 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 lim k0 / N lim 1/ 2e ln( N / 4) 0 . N (14) N Сравнивая (14) с выражением (12), можно видеть, что, как и в случае стандартной модели Хопфилда, требование идеального распознавания существенно уменьшает число распознаваемых паттернов. k q Рис. 3. Для N 1000 показана зависимость от q критического числа паттернов. Сплошная линия – число распознаваемых паттернов kmax , штриховая линия – число паттернов k p , которые распознаются идеально, маркеры – число идеально распознаваемых паттернов, найденное в компьютерном эксперименте На рис. 3 приведены 3 графика ( N =1000). Сплошной линией дана зависимость от q величины kmax (10) (данная кривая повторяет сплошную линию на левой панели рис. 2, но без деления kmax (q) на N =1000). Штриховой линией показана зависимость от q наибольшего номера паттерна, для которого выполняется условие идеального распознавания. Будем обозначать эту характеристику k p (perfect). Она вычисляется подстановкой выражения y ln( N / 4) в (13). Маркером даны результаты компьютерного эксперимента, в котором определялось число паттернов, совпадающих с неподвижными точками сети. Результаты экспериментов усреднялись по 10 случайным матрицам. Мы видим в целом неплохое УДК 004.032.26(06) Нейронные сети 191 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 согласие теоретических результатов том. с компьютерным эксперимен- УДК 004.032.26(06) Нейронные сети 192 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 4. Выводы Хотя в квази-Хеббовской матрице аккумулирована информация о бесконечном числе паттернов ( M ), «катастрофы памяти» не происходит. Память системы ограничена конечным числом паттернов, веса при которых превосходят некоторое критическое значение rc , вычисляемое по максимальному номеру kmax . Паттерны с меньшими весами сетью не распознаются. Если увеличить вес такого паттерна, сделав его больше критического значения rc , то паттерн будет сетью распознаваться. Возможно, что при этом в разряд нераспознаваемых будут вытеснены какие-то другие паттерны, из числа тех, что раньше распознавались. Такое замещение в «актуальной» памяти одних паттернов другими не только не противоречит здравому смыслу, но отвечает общим представлениям о свойствах человеческой памяти. Использование различных весов, во-первых, позволяет избежать «катастрофы памяти», а, во-вторых, наделяет искусственную память свойствами, которые имеют содержательную интерпретацию в психологических терминах. Работа выполнялась при финансовой поддержке программы РАН «Информационные технологии и анализ сложных систем» (проект 1.7) и РФФИ (грант 09-07-00159). Список литературы 1. Hopfield J.J. Neural Networks and Physical Systems with emergent collective computational abilities // Proc. Nat. Acad. Sci. USA, 1982, v. 79, pp. 2554–2558. 2. Parisi G. A memory which forgets // Journal of Physics A (1986). V. 19, № 10. L617-L620. 3. van Hemmen J.L., Keller G. and Kuhn R. Forgetful Memories // Europhysics Letters (1988). V. 5, pp. 663–668. 4. Nadal J.P., Toulouse G., Changeux J.P., Dehaene S. Networks of Formal Neurons and Memory Palimpsets. Europhysics Letters (1986). V.1 (10), pp. 535–542. 5. van Hemmen J.L., Kuhn R. Collective Phenomena in Neural Networks // In: “Models of Neural Networks”, E. Domany, J.L van Hemmen and K. Shulten (Eds.), pp. 1-105, Berlin: Springer, 1992. 6. Карандашев Я.М., Крыжановский Б.В., Литинский Л.Б. Обобщенная модель Хопфилда и статфизический подход: основное уравнение // XIII УДК 004.032.26(06) Нейронные сети 193 ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3 Всероссийская конференция "Нейроинформатика-2011". Сборник научных трудов, часть 1. Москва. 2011. УДК 004.032.26(06) Нейронные сети 194