Документ 837436

реклама

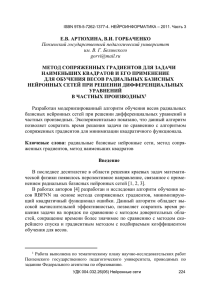

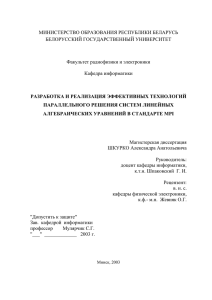

Горбаченко В.И., Артюхина Е.В. Модернизированный алгоритм обучения весов радиальных базисных нейронных сетей при решении краевых задач. // Проблемы информатики в образовании, управлении, экономике и технике: Сб. статей Междунар. научно-техн. конф.– Пенза: ПДЗ, 2010. – С. 80-84. МОДЕРНИЗИРОВАННЫЙ АЛГОРИТМ ОБУЧЕНИЯ ВЕСОВ РАДИАЛЬНЫХ БАЗИСНЫХ НЕЙРОННЫХ СЕТЕЙ ПРИ РЕШЕНИИ КРАЕВЫХ ЗАДАЧ 1 В.И. Горбаченко, Е.В. Артюхина Пензенский государственный педагогический университет им. В.Г. Белинского, г. Пенза, Россия Разработан модернизированный алгоритм обучения весов радиальных базисных нейронных сетей при решении краевых задач. Экспериментально показано, что данный алгоритм позволяет сократить время решения задачи по сравнению с алгоритмом сопряженных градиентов для минимизации квадратичного функционала. Gorbachenko V.I., Artyukhina E.V. Modernized algorithm of training the scales of radial basis neural networks by solving boundary equations. Modernized algorithm of training the scales of radial basis neural networks by solving boundary equations is worked out. It is experimentally proved that this algorithm allows of reduction the time for solving the tasks in comparison with the algorithm of conjugated gradients for minimization of the quadratic functional. Радиальные базисные нейронные сети (RBFNN) находят эффективное применение при решении краевых задач математической физики [1]. Целью работы является разработка и исследование модернизированного алгоритма обучения весов RBFNN. Рассмотрим обучение на примере уравнения Пуассона 2u 2u f x, y , x 2 y 2 x, y , u p x, y , x, y , (1) где – граница области; f и p – известные функции RBFNN выступает аппроксиматором u x wk k rk wk exp rk2 / ak2 , m m k 1 k 1 ( x, y) . функции решения где m – число нейронов, wk – веса сети, rk – рас- стояние от точки x до центра нейрона c k , ak – ширина нейрона k . Обучение сети сводится к настройке векторов параметров RBFNN w, a, c , минимизирующих функционал ошибки I 0.5 R1 , R1 0.5 R 2 , R 2 , (2) где – штрафной множитель, R 1 , R 2 – векторы невязки решения во внутренних и граничных контрольных точках соответственно: (3) R1 Mw f , R 2 Nw p , Работа выполнена по тематическому плану научно-исследовательских работ Пензенского государственного педагогического университета, проводимых по заданию Федерального агентства по образованию. 1 где M – матрица N m с элементами mik 4exp rik2 / ak2 rik2 ak2 ; N ak4 – матрица K m с элементами nik exp rik2 / ak2 ; w – вектор весов, N и K – количество внутренних и граничных контрольных точек; f и p – векторы, компоненты которых равны значениям функций f x, y и p x, y в контрольных точках. Очевидно, что задача обучения RBFNN представляет собой нелинейную задачу наименьших квадратов [2, 3]. Веса w RBFNN входят в функционал ошибки (2) линейно, для обучения выходного слоя сети можно использовать алгоритм сопряженных градиентов. С учетом (3) имеем I Aw, w 2 s, w 0.5 f , f 0.5 p, p , (4) где A 0.5 M TM NT N , s 0.5 M Tf N Tp . Из (4) видно, что задача является задачей минимизации квадратического функционала с симметричной положительно определенной матрицей A . Функционал, используемый в линейном методе наименьших квадратов, содержит симметричную положительно определенную матрицу Грама. В случае обучения RBFNN для решения краевых задач получаем матрицу 1 A MTM NT N , отличающуюся от матрицы Грама. 2 Алгоритм минимизации квадратичного функционала эквивалентен решению системы линейных алгебраических уравнений Aw s , или M T M N T N w M T f N T p . Известно, что обучение RBFNN является плохо обусловленной задачей [4]. Модифицируем метод сопряженных градиентов минимизации функционала (4), основываясь на идеях метода сопряженных градиентов для метода наименьших квадратов (CGLS – Conjugate Gradient Method for Least-Squares) [3, 5]. За основу возьмем алгоритм метода сопряженных градиентов, минимизации квадратичного функционала [6], формально заменив матрицу A на MTM NTN , вектор s на MTf NTp . Чтобы не использовать плохо обусловленную матрицу MTM NT N , учтем, что невязка системы равна k k k k (5) r M Tf N Tp M TM N T N w M T R1 N T R 2 . Учтем также свойство скалярных произведений: Ap ,p M M N Np ,p Mp , Mp Np , Np . k k T T k k k k Получим выражения для невязок с учетом (3), (5) и R1 k 1 R1 k Mp k k , R 2 k 1 R 2 k Np k k , r k 1 k w M T R1 k 1 k k w k p k N T R 2 k 1 k . . Тогда метод сопряженных градиентов минимизации функционала (4) примет вид. На «нулевой» итерации выполняются подготовительные действия: 1. Полагается k 0 . 2. По заданному начальному приближению весов w 0 вычисляются невязки 0 T k T k 0 0 R1 , R 2 и r M R1 N R 2 . 3. В качестве направления движения выбирается p0 r 0 . На первой и следующих итерациях выполняются следующие действия: 4. Вычисляется номер текущей итерации k k 1 . 5. Находится новое приближение решения w k 1 w k k p k , где r , r . Mp , Mp Np , Np k k k k k k k 6. Вычисляются новые невязки R1 k 1 , R 2k 1 , r k 1 . 7. Проверяется условие окончания итерационного процесса, например, k1 r s . Если условие выполняется, то – конец итерационного процесса, иначе – переход на следующий шаг алгоритма. 8. Определяется новое направление движения где k rk 1 , rk 1 rk , rk . p k 1 r k 1 k p k , 9. Переход на шаг 4. 10. Конец алгоритма. Экспериментальное исследование проводилось на примере модельной задачи (1), для f x, y sin x sin y , p x, y 0 . Зависимости функционала ошибки (4) от относительного времени решения представлены на рисунке (за единицу принято время решения модифицированным алгоритмом). 0 10 алгоритм сопряженных градиентов для минимизации квадратичного функционала модифицированный алгоритм -1 10 -2 Функционал ошибки 10 -3 10 -4 10 -5 10 -6 10 0 0.2 0.4 0.6 0.8 Относительное время 1 1.2 1.4 Сравнение алгоритмов Результаты экспериментов показывают, что разработанный алгоритм примерно на 20% сокращает время решения задачи по сравнению с алгоритмом сопряженных градиентов для минимизации квадратичного функционала обучения весов RBFNN. Библиографический список 1. Numerical solution of elliptic partial differential equation using radial basis function neural networks / L. Jianyu, L. Siwei, Q. Yingjiana, H. Yapinga // Neural Networks, 2003, 16(5/6). – P. 729 – 734. 2. Дэннис Дж. мл., Шнабель Р. Численные методы безусловной оптимизации и решения нелинейных уравнений / пер. с англ. – М.: Мир, 1988. – 440 с. 3. Dahlquist G., Bjoeck A. Numerical Mathematics and Scientific Computation. Vol. 2, 3. – SIAM, Philadelphia, 1999. – 673 p. 4. Vorst van der, H. Iterative Krylov Methods for Large Linear Systems. – Cambridge: Cambridge University Press, 2003. – 232 p. 5. Артюхин В.В., Артюхина Е.В., Горбаченко В.И. Радиально-базис-ные нейронные сети для решения краевых задач бессеточными методами // Научная сессия НИЯУ МИФИ– 2010. XII Всерос. науч.-техн. конф. «Нейроинформатика-2010»: сб. науч. тр. – М.: НИЯУ МИФИ, 2010, Ч. 2. – С. 237 – 247.