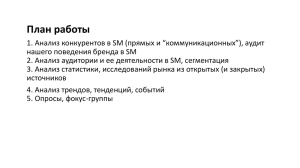

Таргетирование и контекстуализация коммуникации, основаные на сегментации аудитории посредством анализа big data предыдущего опыта методом самообучающихся нейросетей («искусственного интеллекта») Развитие и расширение коммуникационных каналов в современном мире кардинально облегчает технологию массовой коммуникации – причем, позволяя делать ее все более и более симметрично-двусторонней, – с аудиторией. Однако в то же время на стороне реципиента увеличивающийся поток входящей информации радикально снижает когерентность сигнала (восприимчивость сообщения), превращая информационный поток в шум. Многие исследователи описывают динамику «ошумления» экспоненциальным законом; но, даже если темпы ниже, факт снижения восприимчивости аудитории к входящей информации и продолжение этого процесса не вызывают сомнения даже на обывательском уровне. Наименьший ущерб от зашумленности несет формат личной персональной коммуникации, и этим ущербом, в силу его незначительности, можно пренебречь. Тем более, что в конкуренции с массовой коммуникацией, эффективность персонифицированного и таргетированного взаимодействия порядково выигрывает. Ключевая и самая сложная задача для установления такого взаимодействия – прецизионная сегментация аудитории, позволяющая доставить до реципиента сообщение, желательно персонифицированное, но обязательно максимально контекстуализированное – настолько, насколько это позволит реализовать однородность, четкость, определенность целевого сегмента аудитории. В устоявшейся классической технике сегментация аудитории осуществляется, при самом потенциально качественном и точном подходе, методом многомерного статистического и социологического анализа, который ограничен условиями четкого вычислительного порядка, жестких формул, значительной долей допущений, предположений и субъективных корреляций – особенно в случае соизмерения разноформатных по природе и структуре данных; дополнительные или посторонние характеристики же или не могут быть применимы вообще, или при введении значительно увеличивают вероятность ошибки алгоритма в целом. Альтернативный вариант сегментации аудитории, лишенный перечисленных недостатков «ручного» аналитического метода, основан на предложенном в 1984 году принципе самообучаемых нейронных сетей Кохонена, изначально ориентированном на выполнение задач кластеризации. В самом обобщенном представлении, метод позволяет проецировать многомерное пространство данных в пространство более низкой размерности – вплоть до наиболее часто используемых на практике 2-мерных моделей. «Искуственный интеллект», а точнее, нейронная сеть, является математической моделью функционирования и организации нейронных сетей биологического организма (нервных клеток). Цель данной сегментации – или кластерного анализа – минимизировать внутригрупповую дисперсию и максимизировать дисперсию между отдельными сегментами аудитории, и выделить наиболее характерные общие описательные признаки сегмента; причем, в отличие от традиционного статистического анализа, выходные описательные модели сегментов могут и на практикебудут содержать не только повторяющиеся, но и вообще, логически не связанные критерии. Абсолютно по принципу того, как не основанную на математическом анализе субъективную сегментацию и оценку чего-либо дает наш мозг. Это обусловлено важнейшей особенностью нейросетей – возможностью работать в процессе решения одной задачи с различными источниками, форматами и типами данных, анализируя их вне зависимости от классификации и происхождения, и делать выводы. На работу метода не влияют посторонние «шумы» входных данных – составляющие, являющиеся одной из главных причин ошибки традиционной аналитической модели из-за их учета или наоборот необоснованного исключения: в процессе самообучения и самонастройки нейронная сеть отсеивает эти шумы и извлекает релевантные параметры. Это далеко не единственные особенности нейросетей, однако наиболее характерные и важные для задач кластеризации (сегментации аудитории) при анализе big data. На рисунке показана модель нейросети Уоррена Мак-Каллока и Уолтера Питтса. 1) входящий вектор параметров; w – вектор (матрица) весов; 2) сумма – функциональное тело нейрона, складывающий умноженные на веса входящие параметры; 3) функция, определяющая зависимость выходного значения нейрона от поступившего суммарного значения; 4) следующий слой нейронов, либо последний – терминальный нейрон. Из данных блоков собираются сети, имеющие большое количество скрытых слоев, вырабатываемых уже самой сетью в процессе сопоставления, анализа, нахождения зависимостей. Количество нейронов входного слоя сети формально не ограничено. Количество «итоговых» нейронов – нейронов выходного слоя сети – соответствует количеству формируемых сегментов (кластеров); эта величина подбирается в зависимости от необходимости и имеющей значение степени дисперсности соседних групп; в соответствии с необходимым уровнем контекстуализации и персонификации передаваемого в группу информационного сообщения; выше детализация – выше число нейронов выходного слоя. Предел – число индивидуальных реципиентов сообщения. Расширение модели может быть проиллюстрировано следующим примером: Где Вход – входящая группировка нейронов, СУ-1 и СУ-2 – скрытые уровни (количество не ограничено), Выход – выходной уровень, формируемые кластеры (сегменты). Ключевая задача – обучение или «тренировка» нейронной сети; должна быть проведена перед ее применением с целью определения коэффициентов весов нейронов – подающихся входных данных и характеристик сегментируемой целевой аудитории, когда каждый нейрон следующего иерархического получает возможность выдавать объективное результирующее значение. Технология программирования и запуска работы нейросети не представляет сложностей и решается различными путями (например, на уровне таких языков программирования общего назначения, как Python). Некоторой проблемой применения нейросетей является доступность достаточных аппаратно-вычислительных мощностей, ограничивающих скорость передачи сигнала внутри сети; по сравнению с параметрами человеческой мысли, аппаратная составляющая остается слаба. Однако уже сейчас для обработки данных доступны облачные модели организации работы с использованием суперкомпьютеров – они представлены корпорациями Microsoft, Nvidia и так далее; на постсоветском пространстве в начале ноября 2019 года «Сбербанк» запустил самый мощный российский суперкомпьютер Christofari, вошедший в ТОП-30 мировых суперкомпьютеров. По сути дела, Christofari стал платформой для обучения моделей «искуственного интеллекта» с использованием большого объема данных; анонсировано, что с 12 декабря 2019 Christofari станет доступным для сторонних пользователей через «облако» – аналогично другим вычислительным сервисам, в том числе уже упомянутым Microsoft и Nvidia. Таким образом, основной сложностью в расширении применения нейросетей становится наличие исходных данных; обучение сети проходит самостоятельно, но требует «лишь» массива big data для дальнейшего анализа. Постоянно растущим источником данных является сама аудитория – ее потребительское поведение, оставляющее след в виде оплаченных банковской картой покупок и, например, доступных банковским структурам данным по транзакциям; профили в социальных сетях и запросы в поисковых системах, и так далее – абсолютно не связанная по природе и структуре, несоизмеримая традиционными моделями анализа информация. Данное направление сегментации целевой аудитории становится все более универсальным и эффективным средством таргетирования комуникации и контекстуализации передаваемой информации, кардинально увеличивающим эффективность PR и снижающим его стоимость. И наиболее эффективное решение данной задачи становится возможным для структур, способных аккумулировать и «поставлять» на анализ big data.