Информативность непрерывных источников сообщений

реклама

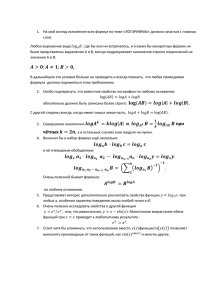

Информативность непрерывных источников сообщений Презентация лекции по курсу «Общая теория связи» © Д.т.н., проф. Васюков В.Н., vasyukov@edu.nstu.ru Новосибирский государственный технический университет, Новосибирск, пр. К. Маркса, 20 Факультет Радиотехники и электроники Кафедра теоретических основ радиотехники Источники непрерывных сообщений Непрерывные источники вырабатывают сообщения, описываемые функциями, принимающими значения из непрерывного множества. Ярким примером непрерывного сообщения является речевое сообщение, описываемое вещественной функцией непрерывного времени: 2 Значение непрерывного сообщения в некоторый отдельный момент времени представляет собой непрерывную случайную величину, описываемую функцией распределения F ( x) Ρ x или плотностью w( x) dF ( x) / dx Введенное ранее понятие энтропии неприменимо к непрерывному источнику, так как неопределенность относительно любого конкретного значения непрерывной случайной величины равна бесконечности: w( x ) x 3 Энтропия непрерывных сообщений Разобьем область определения непрерывной случайной величины на отрезки одинаковой длины x и пронумеруем их при помощи индекса i , : Сопоставим каждому отрезку значение x 'i , равное его середине, и вероятность P ( x 'i ) , равную вероятности попадания в данный интервал исходной непрерывной случайной величины . w( x ) P ( x 'i ) x x 'i 4 Энтропия непрерывных сообщений Разобьем область определения непрерывной случайной величины на отрезки одинаковой длины x и пронумеруем их при помощи индекса i , : Сопоставим каждому отрезку значение x 'i , равное его середине, и вероятность P ( x 'i ) , равную вероятности попадания в данный интервал исходной непрерывной случайной величины . w( x ) P ( x 'i ) x x 'i 5 Для полученной дискретной случайной величины энтропия H ( X ') i P( x 'i )log P( x 'i ) Подставив вместо вероятности ее приближенное значение, получим в пределе при x 0 H ( X ) lim H ( X ') lim w( x 'i )x log w( x 'i ) x x 0 x 0 i lim w( x 'i )log w( x 'i ) x lim w( x 'i )log x x x 0 i x0 i log x w( x)log w( x)dx lim x 0 6 «Индивидуальность» распределения определяется первым слагаемым, которое и принимают в качестве меры информативности непрерывного источника и называют относительной, или дифференциальной энтропией h( X ) w( x)log w( x)dx Дифференциальная энтропия, в отличие от энтропии дискретного источника, самостоятельного смысла не имеет и служит для сравнения информативности различных непрерывных источников между собой 7 Пример. Дифференциальная энтропия источника, описываемого гауссовской плотностью вероятности 2 xm 1 2 2 w( x) e 2 hгаусс ( X ) w( x)log w( x)dx 1 w( x)log dx w( x) 2 2 log e w( x) log 2 x m dx 2 2 log 2 2 log e w( x)dx 2 2 x m w( x)dx log e log 2 log 2 e 2 2 2 2 Пример. Дифференциальная энтропия источника, описываемого равномерной плотностью вероятности /2 h равн ( X ) /2 1 , /2 x/2 w( x) 0 в противном случае 1 1 1 log dx log log Дисперсия равновероятной случайной величины равна D 2 / 12 , тогда 12D h равн ( X ) log log 12 D Для сравнения: 2 e 17.079 hгаусс log 2 e 2 h равн hгаусс Взаимная информация двух непрерывных случайных величин p( xi , y j ) I ( X , Y ) lim p( xi , y j )log x 0 p( xi ) p( y j ) i j y 0 w( xi , y j )xy lim p( xi , y j )log x 0 w( xi )xw( y j )y i j y 0 w( x, y ) w( x, y )log dxdy w( x) w( y ) Это можно переписать в виде I ( X ,Y ) w( y ) w( x | y ) w( x, y )log dxdy w( x) w( y ) w( x, y)log w( x)dxdy w( x, y)log w( x | y)dxdy h( X ) h( X | Y ) где h( X | Y ) w( x, y)log w( x | y)dxdy - условная дифференциальная энтропия Пропускная способность непрерывного канала Пусть колебание на выходе непрерывного канала представляет собой сумму сигнала и шума (статистически независимых) z (t ) x(t ) (t ) Положим, что канал имеет полосу частот, ограниченную частотой F и время действия Т; тогда колебание можно приближённо представить М отсчётами, M 2 FкT то есть вектором с плотностью вероятности Вектор отсчётов шума X x1, x2 ,..., xM w( X ) w x1, x2 ,..., xM 1,2 ,..., M описывается плотностью w() w 1,2 ,..., M Пропускная способность непрерывного канала определяется как 1 max I ( X , Z ) T T w( x) C lim - среднее за время Т количество информации о реализации сигнала x(t) в процессе z(t) Средняя взаимная информация сигнала и наблюдаемого процесса равна I ( X , Z ) h( Z ) h( Z | X ) С учётом аддитивности шума h( Z | X ) w(Z | X ) w() ... w(Z , X )log w(Z | X )dZ h() Пропускная способность непрерывного аддитивного канала 1 C lim max h( Z ) h() T T w( X ) Пропускная способность непрерывного канала с аддитивным белым гауссовским шумом (АБГШ, AWGN) Дифференциальная энтропия шума h() 2 FкT log 2 e 2 FкT log 2 e 2 FкT log 2 ePш Pш 2 N 0 Fк - мощность (дисперсия) шума Дифференциальная энтропия совокупности случайных величин максимальна, если это гауссовские независимые с.в. с нулевым средним; h( Z ) FкT log 2 e( Pc Pш ) ; подставим в 1 max I ( X , Z ) T T w( x) C lim Формула Шеннона для пропускной способности АБГШ-канала Pc Pc C Fк log 1 Fк log 1 P F N ш к 0 Pc Pc C Fк log 1 Fк log 1 P F N ш к 0 При неограниченном расширении полосы пропускания пропускная способность непрерывного канала с АБГШ стремится к пределу Pc Pc C log e 1,443 N0 N0