b 1

реклама

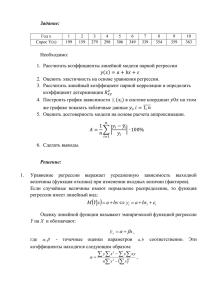

Лекция 2.1 Линейная регрессионная модель для случая одной объясняющей переменной. Метод наименьших квадратов (МНК) Dictionary definition: “Regression is a backward movement, a retreat, a return to an earlier stage of development”. Sir Francis Galton (1822-1911) ввел термин «регрессия», изучая зависимость роста детей от роста родителей. “A regression of children’s height towards the average”. 2 • Регрессионный анализ объединяет широкий круг задач, связанных с построением зависимостей между двумя переменными: X и Y. • X – независимая, объясняющая, экзогенная переменная, регрессор • Y- зависимая, объясняемая, эндогенная переменная, regressand. • На практике исследователь работает с данными (Xi, Yi), i = 1,…,n. 3 Модель парной регрессии Y X1 X2 Xn X Пусть случайные величины Х и Y имеют совместное распределение Определение парной регрессии E(Y|X = Xi) = f(Xi) , i = 1,…,n 7 Модель парной регрессии Y X1 X2 Xn X Уравнение теоретической регрессии Yi = f(Xi) + ui,, i = 1,…,n т.к. при одном и том же Х, Y могут быть разные. Из случайной величины Y выделяем некоторую часть, которая детерминирована иксом, ui - случайная составляющая, добавка. 7 Модель парной регрессии Yi = E(Y|X = Xi) + ui, i = 1,…,n – уравнение теоретической регрессии Какова причина появления случайной составляющей ui (возмущения)? •В модели участвуют не все переменные, влияющие на поведение Y. •Врожденная неопределенность поведения экономических агентов. •Мы используем те величины, которые можем измерить, а не те, которые хотелось бы. •Ошибки измерения. 8 Модель парной регрессии Уравнение теоретической регрессии Yi = f(Xi) + ui в зависимости от f(Xi) может быть линейным, квадратичным, логарифмическим. Рассмотрим линейный случай: f(x) = β1 + β2X – линейно по Х и по параметрам. 9 Модель парной регрессии Y Y b1 b 2 X b1 X1 X2 X3 Xn X Предположим, что переменная Y является линейной функцией переменной X с неизвестными параметрами b1 и b2, которые мы хотим оценить. 4 Модель парной регрессии Y Y b1 b 2 X b1 Q1 X1 Q2 X2 Q3 X3 Qn Xn X Если все точки расположены на одной прямой линии, то достаточно легко найти оценки параметров b1 и b2. 5 Модель парной регрессии Pn Y Y b1 b 2 X P1 b1 Q1 X1 Q2 P2 X2 Q3 Qn P3 X3 Xn X Но на практике взаимоотношения между переменными X и Y не являются в точности линейными, т.е. пары наблюдений не располагаются на прямой линии. 6 Модель парной регрессии Pn Y Y b1 b 2 X P1 b1 Q1 X1 Q2 P2 X2 Q3 Qn P3 X3 Xn X Специфицируем модель следующим образом: Y = b1 + b2X + u, где u – возмущение. 10 Модель парной регрессии Pn Y Y b1 b 2 X u1 P1 b1 Q1 b1 b 2 X 1 X1 Q Q2 P2 X2 Q3 n P3 X3 Xn X Таким образом, каждое значение переменной Y можно разделить на две части: детерминированную, β1 + β2X, и случайную u. 11 Модель парной регрессии Pn Y P1 P2 X1 X2 P3 X3 Xn X Но на практике мы не имеем линии Y = β1 + β2X , а имеем только n пар наблюдений. 12 Модель парной регрессии Pn Y Yˆ b1 b2 X P1 P2 b1 X1 X2 P3 X3 Xn X По n парам наблюдений мы должны построить оценки параметров β1 и β2 (соответственно b1 и b2). Тогда линия ^ Y = b1 + b2X будет являться аппроксимацией линии Y = b1 + b2X. 13 Модель парной регрессии Y Y (реальные значения) Yˆ (оцененные значения) Pn Yˆ b1 b2 X R3 P1 R1 b1 X1 R2 P2 X2 Rn P3 X3 Xn X На рисунке проведена линия выборочной регрессии, лежащие на ней точки Ri называются оцененными значениями переменной Y. 14 Модель парной регрессии Y Y Yˆ Pn R3 e1 R2 P1 R1 b1 X1 e2 P2 X2 Yˆ b1 b2 X e4 Y Yˆ e (остатки) Rn e3 P3 X3 Xn X Разности между действительными и оцененными значениями переменной Y называются остатками регрессии. 15 Модель парной регрессии Y Y Yˆ Pn Yˆ b1 b2 X R3 P1 b1 R1 b1 X1 R2 P2 X2 Rn Y b1 b 2 X P3 X3 Xn X Серым цветом проведена линия теоретической регрессии, а черным – выборочной регрессии. 16 Модель парной регрессии Y Y Yˆ Pn Yˆ b1 b2 X Y b1 b 2 X P1 b1 Q1 b1 X1 Q2 P2 X2 Q3 Qn P3 X3 Xn X На рисунке изображены возмущения ui (отклонения Yi от линии теоретической регрессии). 17 Модель парной регрессии Y Y Yˆ Pn Yˆ b1 b2 X R3 P1 b1 R1 b1 X1 R2 P2 X2 Rn Y b1 b 2 X P3 X3 Xn X На рисунке изображены остатки ei (отклонения от линии выборочной регрессии). 18 Модель парной регрессии Y Y Yˆ Pn Yˆ b1 b2 X R3 P1 b1 R1 b1 X1 R2 P2 X2 Rn Y b1 b 2 X P3 X3 Xn X Если качество подгонки регрессии хорошее, то остатки и значения возмущений близки, но они имеют разную природу. 19 Модель парной регрессии Y Y Yˆ Pn un Yˆ b1 b2 X Y b1 b 2 X Qn b1 b 2 X n b1 b1 X1 X2 X3 Xn X Существует два способа декомпозиции значений Y: с помощью теоретической регрессии и с помощью выборочной регрессии. 20 Модель парной регрессии Y Y Yˆ Pn un Yˆ b1 b2 X Y b1 b 2 X Qn b1 b 2 X n b1 b1 X1 X2 X3 Xn X При использовании теоретической регрессии Y разлагается на детерминированную (b1 + b2X ) и случайную(u) части. 21 Модель парной регрессии Y Y Yˆ Pn un Qn Yˆ b1 b2 X Y b1 b 2 X b1 b 2 X n b1 b1 X1 X2 X3 Xn X Это разложение является чисто теоретическим (т.к. параметров b1 и b2 мы не знаем) и будет использовано при анализе свойств оценок коэффициентов регрессии. 22 Модель парной регрессии Y Y Yˆ Pn en Yˆ b1 b2 X Rn Y b1 b 2 X b1 b2 X n b1 b1 X1 X2 X3 Xn X Другая декомпозиция легко выполнима на практике при известных b1 и b2. 23 Оценка коэффициентов выборочной регрессии Метод наименьших квадратов (МНК) оценки коэффициентов регрессии состоит в Минимизации суммы квадратов остатков регрессии RSS (residual sum of squares) n RSS e e ... e i 1 2 i 2 1 2 n 24 МНК Mинимизация RSS (residual sum of squares), n RSS ei2 e12 ... en2 i 1 А не суммы остатков n e i 1 i e1 ... en Почему минимизируется сумма квадратов остатков, а не сумма остатков? 25 Pn Y Y P1 P2 X1 X2 P3 X3 Xn X На примере горизонтальной линии легко увидеть, что сумма остатков равна 0, остатки разных знаков компенсируют друг друга, хотя и могут быть велики по абсолютной величине. Это будет иметь место и в общем случае. 26 P4 Y Y P1 P2 X1 X2 P3 X3 X4 X МНК является не единственным возможным критерием, но очень удобен для практического применения (обладая и другими замечательными свойствами). 27