Курс: Общий физический практикум Склярова Елена Александровна Сегодня: _________________ 2009 г.

реклама

Сегодня: _________________ 2009 г.

Курс: Общий физический практикум

Склярова Елена Александровна

Сегодня: _______________ 2009 г.

Лекция № 10

Тема: Численное моделирование.

Метод Монте-Карло.

Содержание лекции:

1. История

1.1 Алгоритм Буффона для определения числа Пи

1.2 Связь стохастических процессов и дифференциальных уравнений

1.3 Рождение метода Монте-Карло в Лос-Аламосе

1.4 Дальнейшее развитие и современность

2. Интегрирование методом Монте-Карло

2.1 Обычный алгоритм Монте-Карло интегрирования

2.2 Использование выборки по значимости

3. Оптимизация

4. Применение в физике

4.1 Алгоритм Метрополиса

4.2 Динамическая (кинетическая) формулировка

4.3 Прямое моделирование методом Монте-Карло

4.4 Квантовый метод Монте-Карло

Метод Монте-Карло – это …

Ме́тод Мо́нте-Ка́рло (методы Монте-Карло) —

общее название группы численных методов,

основанных на получении большого числа

реализаций стохастического (случайного)

процесса, который формируется таким образом,

чтобы его вероятностные характеристики

совпадали с аналогичными величинами

решаемой задачи.

Используется для решения задач в областях

физики, математики, экономики, оптимизации,

теории управления и др.

Алгоритм Буффона для определения числа Пи

Случайные величины

использовались для решения

различных прикладных задач

достаточно давно.

Примером может служить способ

определения числа Пи, который был

предложен Буффоном еще в 1777 году.

Суть метода была в бросании

иглы длиной L на плоскость,

расчерченную параллельными

прямыми, расположенными на

расстоянии r друг от друга.

Алгоритм Буффона для определения числа Пи

Вероятность (как видно из дальнейшего

контекста, речь идёт не о вероятности, а о

математическом ожидании количества

пересечений за один опыт; вероятностью это

становится лишь при условии, что r > L) того, что

отрезок пересечет прямую, связана с числом Пи:

где

A — расстояние от начала иглы до ближайшей к ней

прямой;

θ — угол иглы относительно прямых.

Алгоритм Буффона для определения числа Пи

Этот интеграл просто взять:

(при условии, что r > L), поэтому подсчитав долю

отрезков, пересекающих прямые, можно

приближенно определить это число. При

увеличении количества попыток точность

получаемого результата будет увеличиваться.

Алгоритм Буффона для определения числа Пи

В 1864 году капитан Фокс, выздоравливая после ранения,

чтобы как-то занять себя, реализовал эксперимент по бросанию

иглы. Результаты представлены в следующей таблице:

Число

Число

бросаний пересечений

Длина

иглы

Расстояние

Между

прямыми

Враще

ние

Зн-ие

Пи

Первая

попытка

500

236

3

4

отсутству

ет

3.1780

Вторая

попытка

530

253

3

4

присутст

вует

3.1423

Третья

попытка

590

939

5

2

присутст

вует

3.1416

Комментарии:

Вращение плоскости применялось (и как показывают результаты — успешно)

для того, чтобы уменьшить систематическую ошибку.

В третьей попытке длина иглы была больше расстояния между линиями, что

позволило не увеличивая числа бросаний эффективно увеличить число

событий и повысить точность.

Связь стохастических процессов и дифференциальных уравнений

Создание математического аппарата

стохастических методов началось в конце 19-го века.

В 1899 году лорд Релей показал, что одномерное

случайное блуждание на бесконечной решётке может

давать приближенное решение параболического

дифференциального уравнения.

Колмогоров в 1931 году дал большой толчок

развитию стохастических подходов к решению

различных математических задач, поскольку он

сумел доказать, что цепи Маркова связаны с

некоторыми интегро-дифференциальными

уравнениями.

Связь стохастических процессов и дифференциальных уравнений

В 1933 году Петровский показал, что случайное

блуждание, образующее Марковскую цепь,

асимптотически связано с решением эллиптического

дифференциального уравнения в частных

производных.

После этих открытий стало понятно, что

стохастические процессы можно описывать

дифференциальными уравнениями и,

соответственно, исследовать при помощи хорошо на

тот момент разработанных математических методов

решения этих уравнений.

Рождение метода Монте-Карло в Лос-Аламосе

Сначала Энрико Ферми в 1930-х годах в Италии, а

затем Джон фон Нейман и Станислав Улам в 1940-х в

Лос-Аламосе предположили, что можно использовать

связь между стохастическими процессами и

дифференциальными уравнениями «в обратную

сторону». Они предложили использовать

стохастический подход для аппроксимации

многомерных интегралов в уравнениях переноса,

возникших в связи с задачей о движении нейтрона в

изотропной среде.

Рождение метода Монте-Карло в Лос-Аламосе

Идея была развита Станиславом Уламом,

который, по иронии судьбы, также как и Фокс

боролся с вынужденным безделием во время

выздоровления после болезни, и, раскладывая

пасьянсы, задался вопросом, какова вероятность

того, что пасьянс «сложится».

Ему в голову пришла идея, что вместо того,

чтобы использовать обычные для подобных задач

соображения

комбинаторики,

можно

просто

поставить «эксперимент» большое число раз и, таким

образом, подсчитав число удачных исходов, оценить

их вероятность. Он же предложил использовать

компьютеры для расчётов методом Монте-Карло.

Рождение метода Монте-Карло в Лос-Аламосе

Появление первых электронных компьютеров,

которые могли с большой скоростью

генерировать псевдослучайные числа, резко

расширило круг задач, для решения которых

стохастический подход оказался более

эффективным, чем другие математические

методы.

После этого произошёл большой прорыв и метод

Монте-Карло применялся во многих задачах,

однако его использование не всегда было

оправдано из-за большого количества

вычислений, необходимых для получения ответа

с заданной точностью.

Рождение метода Монте-Карло в Лос-Аламосе

Годом

рождения

метода

Монте-Карло

считается 1949 год, когда в свет выходит статья

Метрополиса и Улама «Метод Монте-Карло».

Название метода происходит от названия

города в княжестве Монако, широко известного

своими многочисленными казино, поскольку

именно рулетка является одним из самых

широко известных генераторов случайных

чисел.

Станислав

Улам

пишет

в

своей

автобиографии «Приключения математика»,

что название было предложено Метрополисом

в честь его дяди, который был азартным

игроком.

Дальнейшее развитие и современность

В 1950-х годах метод использовался для расчётов при

разработке водородной бомбы. Основные заслуги в развитии метода

в это время принадлежат сотрудникам лабораторий ВВС США и

корпорации RAND.

В 1970-х годах в новой области математики — теории

вычислительной сложности было показано, что существует класс

задач, сложность (количество вычислений, необходимых для

получения точного ответа) которых растёт с размерностью задачи

экспоненциально. Иногда можно, пожертвовав точностью, найти

алгоритм, сложность которого растёт медленнее, но есть большое

количество задач, для которого этого нельзя сделать (например,

задача определения объёма выпуклого тела в n-мерном евклидовом

пространстве) и метод Монте-Карло является единственной

возможностью для получения достаточно точного ответа за

приемлемое время.

В настоящее время основные усилия исследователей

направлены на создание эффективных Монте-Карло алгоритмов

различных физических, химических и социальных процессов для

параллельных вычислительных систем.

Интегрирование методом Монте-Карло

Предположим, необходимо взять

интеграл от некоторой функции.

Воспользуемся неформальным

геометрическим описанием интеграла

и будем понимать его как площадь под

графиком этой функции.

Для определения этой площади можно

воспользоваться одним из обычных

численных методов интегрирования:

разбить отрезок на подотрезки, подсчитать

площадь под графиком функции на каждом

из них и сложить.

Численное интегрирование функции

детерминистическим методом

Интегрирование методом Монте-Карло

Предположим, что для функции,

представленной на рисунке, достаточно

разбиения на 25 отрезков и,

следовательно, вычисления 25 значений

функции. Представим теперь, мы имеем

дело с n-мерной функцией. Тогда нам

необходимо 25n отрезков и столько же

вычислений значения функции. При

размерности функции больше 10 задача

становится огромной.

Поскольку пространства большой

размерности встречаются, в частности, в

задачах теории струн, а также многих

других физических задачах, где имеются

системы со многими степенями свободы,

необходимо иметь метод решения,

вычислительная сложность которого бы

не столь сильно зависела от

размерности. Именно таким свойством

обладает метод Монте-Карло.

Численное интегрирование функции

детерминистическим методом

Обычный алгоритм Монте-Карло интегрирования

Для определения площади под графиком

функции можно использовать следующий

стохастический алгоритм:

-- ограничим функцию

прямоугольником (n-мерным

параллелепипедом в случае многих

измерений), площадь которого Spar

можно легко вычислить;

-- «набросаем» в этот прямоугольник

(параллелепипед) некоторое количество

точек (N штук), координаты которых

будем выбирать случайным образом;

-- определим число точек (K штук),

которые попадут под график функции;

-- площадь области, ограниченной

функцией и осями координат, S даётся

следующим выражением

Численное интегрирование функции

методом Монте-Карло

Обычный алгоритм Монте-Карло интегрирования

Для малого числа измерений интегрируемой

функции производительность Монте-Карло

интегрирования гораздо ниже, чем

производительность детерминистических

методов.

Тем не менее, в некоторых случаях, когда

функция задана неявно, а необходимо

определить область, заданную в виде сложных

неравенств, стохастический метод может

оказаться более предпочтительным.

Использование выборки по значимости

Очевидно, что точность вычислений

можно увеличить, если область,

ограничивающая искомую функцию, будет

максимально к ней приближена. Для этого

необходимо использовать случайные с

распределением, форма которого

максимально близка к форме интегрируемой

функции. На этом основан один из методов

улучшения сходимости в вычислениях

методом Монте-Карло: выборка по

значимости.

Применение в физике

Компьютерное моделирование играет в

современной физике важную роль и метод

Монте-Карло является одним из самых

распространённых во многих областях от

квантовой физики до физики твёрдого тела,

физики плазмы и астрофизики.

Алгоритм Метрополиса

Традиционно метод Монте-Карло применялся для

определения различных физических параметров

систем, находящихся в состоянии термодинамического

равновесия. Предположим имеется набор W(S)

возможных состояний физической системы S. Для

определения среднего значения

некоторой

величины A необходимо рассчитать

где суммирование производится по всем

состояниям S из W(S), P(S) — вероятность состояния S.

Прямое моделирование методом Монте-Карло

Прямое моделирование методом Монте-Карло

какого-либо физического процесса подразумевает

моделирование поведения отдельных элементарных

частей физической системы.

По сути это прямое моделирование близко к

решению задачи из первых принципов, однако

обычно для ускорения расчётов допускается

применение каких-либо физических приближений.

Примером могут служить расчёты различных

процессов методом молекулярной динамики: с одной

стороны система описывается через поведение её

элементарных составных частей, с другой стороны,

используемый потенциал взаимодействия зачастую

является эмпирическим.

Прямое моделирование методом Монте-Карло

Примеры прямого моделирования методом

Монте-Карло:

Моделирование облучения твёрдых тел ионами

в приближении бинарных столкновений.

Прямое Монте-Карло моделирование

разреженных газов.

Большинство кинетических Монте-Карло

моделей относятся к числу прямых (в частности,

исследование молекулярно-пучковой эпитаксии).

Квантовый метод Монте-Карло

Квантовый метод Монте-Карло широко применяется

для исследования сложных молекул и твёрдых тел. Это

название объединяет несколько разных методов.

Первый из них это Вариационный метод МонтеКарло, который по сути является численным

интегрированием многомерных интегралов,

возникающих при решении уравнения Шрёдингера.

Для решения задачи, в которой участвует 1000

электронов, необходимо взятие 3000-мерных

интегралов, и при решении таких задач метод МонтеКарло имеет огромное преимущество в

производительности по сравнению с другими

численными методами интегрирования.

Другая разновидность метода Монте-Карло — это

диффузионный метод Монте-Карло.

Общее представление о методе

Метод Монте–Карло —

это численный метод

решения математических

задач при помощи

моделирования случайных

величин.

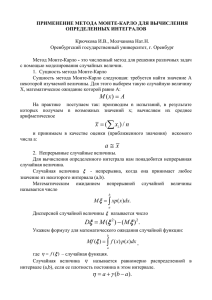

Происхождение метода Монте-Карло

Датой рождения метода Монте-Карло принято считать

1949 г., когда появилась статья под названием «The Monte

Carlo method». Создателями этого метода считают

американских математиков Дж. Неймана и С. Улама.

Любопытно, что теоретическая основа метода была

известна давно.

Более того, некоторые задачи статистики

рассчитывались иногда с помощью случайных выборок,

т. е. фактически методом Монте-Карло.

Однако до появления компьютеров этот метод не мог

найти сколько-нибудь широкого применения, ибо

моделировать случайные величины вручную — очень

трудоемкая работа.

Таким образом, возникновение метода Монте-Карло

как весьма универсального численного метода стало

возможным только благодаря появлению компьютеров.

Само название «Монте-Карло» происходит от города

Монте-Карло в княжестве Монако, знаменитого своими

казино. Дело в том, что одним из простейших

механических приборов для получения случайных

величин является рулетка.

Происхождение метода Монте-Карло

Для того чтобы понять,

о чем пойдет речь,

рассмотрим простой

пример. Предположим, что

нам нужно вычислить

площадь плоской фигуры S.

Это может быть

произвольная фигура с

криволинейной границей,

заданная графически или

аналитически, связная или

состоящая из нескольких

кусков. Пусть это будет

фигура, изображенная на

рис.1, и предположим, что

она вся расположена внутри

единичного квадрата.

Рис.1 Вычисление

площади фигуры

Квантовый метод Монте-Карло

Выберем внутри квадрата множество случайных

точек N.

Обозначим через N' число точек, попавших при

этом внутрь S.

Геометрически очевидно, что

площадь S приближенно равна отношению N'/N.

Чем больше N, тем больше точность этой оценки.

Например, выберем случайным образом 44

точки.

Пусть 13 из них оказались внутри S.

Отношение N'/N равно 13/44=0,30, в то время как

истинная площадь S равна 0,35.

Две особенности метода Монте-Карло

Первая особенность метода - простая

структура вычислительного алгоритма.

Как правило, составляется программа для

осуществления одного случайного

испытания (надо выбрать случайную точку в

квадрате и проверить, принадлежит ли она

S).

Затем это испытание повторяется N раз,

причем каждый опыт не зависит от всех

остальных, и результаты всех опытов

усредняются.

Поэтому иногда метод Монте- Карло

называют методом статистических

испытаний.

Две особенности метода Монте-Карло

Вторая особенность метода - погрешность

вычислений, как правило, пропорциональна

D N , где D - некоторая постоянная. N - число

испытаний.

Отсюда видно, что для того, чтобы

уменьшить погрешность в 10 раз (иначе говоря,

чтобы получить в ответе еще один верный

десятичный знак), нужно увеличить N (т. е. объем

работы) в 100 раз.

Однако одну и ту же задачу можно решать

различными вариантами метода Монте-Карло,

которым отвечают различные значения D.

Во многих задачах удается значительно

увеличить точность, выбрав способ расчета,

которому соответствует значительно меньшее

значение D.

Задачи, решаемые методом Монте-Карло

Во-первых, метод Монте-Карло позволяет

моделировать любой процесс, на протекание

которого влияют случайные факторы.

Во-вторых, для многих математических

задач, не связанных с какими-либо

случайностями, можно искусственно придумать

вероятностную модель (и даже не одну),

позволяющую решать эти задачи (например, для

рис.1).

Таким образом, можно говорить о методе

Монте-Карло как об универсальном методе

решения математических задач.

Особенно интересно, что в некоторых

случаях выгодно отказаться от моделирования

истинного случайного процесса и вместо этого

использовать искусственную модель.

Задачи, решаемые методом Монте-Карло

Вернемся к примеру (рис.1).

Для расчета нам нужно было

выбирать случайные точки в

единичном квадрате. Как это

сделать физически?

Представим такой эксперимент.

Рис. 1 с фигурой S и квадратом

повешен на стену в качестве

мишени.

Стрелок, находящийся на

некотором расстоянии от стены,

стреляет N раз, целясь в центр

квадрата. Конечно, все пули не

будут ложиться точно в центр: они

пробьют на мишени N случайных

точек.

Можно ли по этим точкам

оценить площадь S?

Задачи, решаемые методом Монте-Карло

Результат такого опыта

изображен на рис. 2.

В этом опыте N = 44,

N'= 27 и N'/N = 0,61, что

превышает истинное значение

площади (0,35) почти в 2 раза.

Впрочем, и так ясно, что

при очень высокой

квалификации стрелка

результат опыта будет очень

плохим, так как почти все пули

будут ложиться вблизи центра

и попадут в S .

Рис. 2. Неравномерное

распределение точек

Задачи, решаемые методом Монте-Карло

Нетрудно понять, что наш метод вычисления площади

будет справедлив только тогда, когда случайные точки будут не

«просто случайными», а еще и «равномерно разбросанными» по

всему квадрату. Чтобы придать этим словам точный смысл,

необходимо познакомиться с определением случайных величин

и некоторыми их свойствами.

Вообще, при математическом описании модели любого

сколько-нибудь сложного процесса или явления всегда возникает

задача учета случайности.

В течение долгого периода исследователи ограничивались

рассмотрением разного рода игр, особенно игр в кости,

поскольку их изучение позволяет ограничиваться простыми и

прозрачными математическими моделями.

Однако следует заметить, что многие отлично понимали то,

что позднее (в 1657 году) было прекрасно сформулировано X.

Гюйгенсом: "...Я полагаю, что при внимательном изучении

предмета читатель заметит, что имеет дело не только с

игрой, но здесь закладываются основы очень интересной и

глубокой теории".

И эта теория, изучающая количественные закономерности

случайных явлений, была создана и названа теорией

вероятностей.

Случайные величины

За последние десятилетия неизмеримо выросла роль,

которую играет теория вероятностей в современном

естествознании. После того, как молекулярные представления

о строении вещества получили всеобщее признание, стало

неизбежным широкое использование теории вероятностей в

физике и химии.

Заметим, что с точки зрения молекулярной физики

каждое вещество состоит из огромного числа малых частиц,

находящихся в непрерывном движении и в процессе этого

движения взаимодействующих друг с другом. Естественно,

что при таких условиях обычные для физических теорий

методы математических исследований становятся

бессмысленными.

Теория вероятностей развилась из потребностей

практики: в абстрактной форме она отражает закономерности,

присущие случайным событиям массового характера. Эти

закономерности играют исключительно важную роль в

физике, химии, различных технических дисциплинах,

экономике, военном деле и так далее.

Случайные величины

До некоторого времени теория вероятностей

представляла собой еще не сложившуюся

математическую науку, в которой основные понятия

были недостаточно корректно определены.

Сказанное относится к так называемой классической

теории вероятностей.

В 1900 году на II Международном математическом

конгрессе в Париже немецкий ученый Д. Гильберт

сделал доклад, в котором указал 23 важнейшие

проблемы, стоящие перед математикой.

Одна из них — аксиоматическое построение

теории вероятностей. В настоящее время эта

проблема успешно решена. Наиболее удачный

подход к построению аксиоматической теории

вероятностей предложил А. Н. Колмогоров. Этот

подход тесно связывает теорию вероятностей с

современной теорией меры, а также теорией

множеств.

Некоторые определения

Опыт — это осуществление какого-либо

комплекса условий, который может быть

воспроизведен много раз.

Под событием будем понимать результат

опыта или наблюдения.

События могут быть элементарными

(неразложимыми) и составными

(разложимыми).

Элементарное событие — это событие,

которое происходит в результате единичного

опыта.

Некоторые определения

Составное событие — это совокупность

элементарных событий.

Пример событий: Игральный кубик

подбрасывается два раза. Пусть составное

событие определено следующим образом:

"сумма выпавших цифр равна 6". Тогда

элементарные события будут: "5 + 1", "4 + 2",

"3 + 3", "2 + 4" и "1 + 5". Любые другие

сочетания не относятся к рассматриваемому

составному событию.

Некоторые определения

Генеральной совокупностью называют

совокупность событий, которые могут быть

реализованы в результате бесконечного

числа однотипных опытов.

Выборочной совокупностью, или просто

выборкой, называют совокупность случайно

отобранных событий из генеральной

совокупности.

Объемом совокупности называют число

событий этой совокупности.

Некоторые определения

Случайной величиной будем

называть величину, которая в

результате опыта (наблюдения,

испытания) может принять одно из

возможных значений, но какое именно

— неизвестно.

Вероятность некоторого события

— это мера его "благоприятствия".

Некоторые определения

События будем называть равновозможными,

если мера их "благоприятствия" одинакова.

В реальных условиях, когда количество

опытов конечно, мера "благоприятствия"

определяется не вероятностью, а частостью.

Пусть событие А наблюдалось в m опытах из

n опытов (испытаний).

Тогда частость события А - W(A)

определяется формулой:

W(A)=m/n.

(1)

Когда n достаточно велико, то "работает"

одна из предельных теорем (закон больших

чисел — теорема Бернулли), и может быть

записано приближенное равенство:

Р(А) W(А),

где Р(А) — вероятность события А.

(2)

Некоторые определения

Отметим, что по принятому в теории вероятностей

соглашению вероятность произвольного события

полагается изменяющейся от 0 до 1.

При этом нулевая вероятность соответствует

невозможному событию (которое никогда произойти не

может), а единичная – достоверному событию (которое

обязательно произойдет).

Слова «случайная величина» в обыденном смысле

употребляют тогда, когда хотят подчеркнуть, что

неизвестно, каким будет конкретное значение этой

величины, причем иногда за этими словами скрывается

просто незнание, какова эта величина.

Некоторые определения

Однако математик употребляет эти же слова,

вкладывая в них вполне определенное содержание.

Действительно, говорит он, мы не знаем, какое значение

примет эта величина в данном конкретном случае, но

мы знаем, какие значения она может принимать, и

знаем, каковы вероятности тех или иных значений.

На основании этих данных мы не можем точно

предсказать результат одного испытания, связанного с

этой случайной величиной, но можем весьма надежно

предсказать совокупность результатов большого числа

испытаний. Чем больше испытаний (как говорят, чем

больше статистика), тем точнее будут наши

предсказания.

Итак, чтобы задать случайную величину, надо

указать, какие значения она может принимать и каковы

вероятности этих значений.

Дискретные случайные величины

Характеристики дискретных случайных величин

Случайная величина y называется дискретной,

если она может принимать дискретное множество

значений y1, y2, ..., yn.

В теории вероятностей рассматриваются также

дискретные случайные величины, которые могут

принимать бесконечное число значений.

Дискретная случайная величина Y определяется

таблицей

y1

y

p1

y2

p2

yn

pn

(3)

где y1, y2, ..., yn— возможные значения величины y,

а р1, р2, …pn -соответствующие им вероятности.

Дискретные случайные величины

Точнее говоря, вероятность того, что случайная величина

y примет значение yi

(обозначим ее через P{y = yi}), равна pi :

P{y = yi} = pi

Таблица (3) называется распределением случайной

величины.

Числа х1, х2, ..., хn могут быть, вообще говоря, любыми.

Однако вероятности р1, р2, ..., рn должны удовлетворять двум

условиям:

1) все pi положительны:

pi 0;

(4)

2) сумма всех pi равна 1:

р1 + р2 + … + рn = 1

(это условие означает, что y обязана в каждом случае

принять одно из значений у1, у2, ..., уn ).

(5)

Математическое ожидание, мода, медиана

Математическим ожиданием дискретной

случайной величины y называется сумма

произведений всех ее возможных значений

на их вероятности:

(6)

n

y M ( y ) yi pi

i 1

Чтобы выяснить физический смысл этой

величины, запишем ее в следующем виде:

n

M ( y ) yi pi

i 1

n

p

i 1

i

Отсюда видно, что M(y) - это (генеральное)

среднее значение величины y, причем более

вероятные значения y входят в сумму с

большими весами.

Математическое ожидание, мода, медиана

Усреднение с весами очень часто

встречается в самых различных областях науки.

Например, в механике: если в точках х1, х2, ...,

хn (на оси Ох) расположены массы m1, m 2, ..., m n ,

то абсцисса центра тяжести этой системы

вычисляется по формуле

x mi pi mi

i 1

i 1

n

n

1

Конечно, в этом случае сумма всех масс не

обязана равняться единице.

Математическое ожидание, мода, медиана

Отметим основные свойства математического

ожидания.

Если с - какая-нибудь не случайная величина, то

М(y + c) = М(y) + c

М(c y) = cМ(y)

(7)

(8)

Если y, z — любые случайные величины, то

М(y + z) = М(y) + М(z).

(9)

Математическое ожидание — важная, но не

единственная характеристика "усредненного" значения

случайной величины.

"Усредненное" значение может характеризоваться

также модой и медианой.

Математическое ожидание, мода, медиана

Модой случайной величины называется

ее наиболее вероятное значение (то, для

которого вероятность достигает максимума).

Медианой случайной величины

называется такое значение m из области

определения случайной величины, для

которого

Р{y < m} Р{y > m}.

Из этого следует, что для случайной

величины принятие значения, меньшего

медианы, равновероятно принятию

значения, большего медианы.

Математическое ожидание, мода, медиана

Математическое ожидание, мода и медиана

случайной величины по-разному характеризуют

усредненное значение случайной величины. Эти

различия становятся понятными из следующего

примера.

Если некоторая фирма хочет оценить необходимое

количество денег для выдачи зарплаты, ее интересует

средняя зарплата сотрудника, то есть математическое

ожидание зарплаты сотрудника, рассматриваемой как

случайная величина.

При устройстве на работу будущего сотрудника

должна интересовать не средняя зарплата, а ее мода —

заработная плата, получаемая большинством

сотрудников.

Сопоставление собственной заработной платы с

медианой заработной платы говорит сотруднику о том,

принадлежит ли он к хорошо или плохо оплачиваемой

части сослуживцев.

Дисперсия

Дисперсией дискретной случайной

величины называется число

2

D(y) = М(y - М(y) )2 = ( y y )

(10)

Следовательно, дисперсия D(y) - это

математическое ожидание квадрата отклонения

случайной величины от ее среднего значения

М(y).

Очевидно, всегда D(y) > 0.

Математическое ожидание и дисперсия важнейшие числовые характеристики случайной

величины y. Каково их практическое значение?

Дисперсия

Если мы будем наблюдать величину y много раз и

получим значения y1, y2, ..., yn, то среднее

арифметическое от этих значений будет близко к М(y):

y y

1

2

N

y

N

M ( y)

(11)

Дисперсия D(y) характеризует разброс этих

значений около среднего М(y).

Формулу (10) для дисперсии можно преобразовать

с помощью формул (7)-(9) :

D(y) = М[y2- 2М(y) y + M(y)2] = M(y2) - 2M(y)M(y) + M(y)2,

Откуда

D(y) = М(y2) - M(y)2.

Вычислять дисперсию по этой формуле обычно

проще, чем по формуле (10) .

(12)

Дисперсия

Отметим основные свойства дисперсии.

Если с - какая-нибудь не случайная величина, то

D(y +c) = D(y) ,

D(cy) = c2 D(y) .

(13)

(14)

Важную роль в теории вероятностей играет

понятие независимости случайных величин.

В действительности это довольно сложное

понятие, но в простейших случаях оно очевидно:

допустим, что кроме случайной величины y мы

наблюдаем еще за случайной величиной z. Если

распределение величины y не меняется от того, что

нам уже известно значение, которое приняла

величина z, то естественно считать, что y от z не

зависит.

Дисперсия

Для независимых случайных величин y и z справедливы

следующие соотношения:

М(y z) = М(y)M(z),

(15)

D(y +z)=D(y) + D(z).

(16)

Рассмотрим случайную величину с распределением

2

3

4

5

6

1

~

1

6

1

6

1

6

1

6

1

6

1

6

Очевидно, что реализацией этой величины можно

считать число очков, выпадающих на игральной кости:

любое значение одинаково вероятно.

Вычислим математическое ожидание по формуле

(6):

1

M ( ) 1

6

1

6 3,5;

6

дисперсию по формуле (12):

1

D( ) M ( ) ( M ( )) 1

6

2

2

2

1

6 (3,5) 2 2,917

6

2

Дисперсия

Рассмотрим еще один пример. Возьмем

случайную величину

4

3

1

2

1

2

Реализацией этой величины можно считать

игру в орлянку с условием, что, например, орел это 3 очка, а решетка - 4 очка. В этом случае

М() = 0,5 3 + 0,5 4 = 3,5;

D() = 0,5 (З2 + 42) – (3,5)2 = 0,25.

Мы видим, что М() = М(), но D() < D().

Последнее можно было легко предвидеть,

так как значения могут отличаться от 3,5 только

на ±0,5, в то время как в значениях разброс

может достигать ±2,5.

Непрерывные случайные величины

Предположим, что на плоскости в начале

координат расположено некоторое количество

радия. При распаде каждого атома радия из него

вылетает -частица. Направление ее будем

характеризовать углом .

Так как и теоретически, и практически

возможны любые направления вылета, то эта

случайная величина может принимать любое

значение от 0 до 2.

Мы будем называть случайную величину

непрерывной, если она может принимать любое

значение из некоторого интервала (а, b).

Непрерывные случайные величины

Непрерывная случайная величина

определяется заданием интервала (а,b),

содержащего возможные значения этой

величины, и функции р(х), которая называется

плотностью вероятностей случайной

величины (или плотностью распределения ).

Физический смысл р(х) следующий: пусть

(а',b') - произвольный интервал, содержащийся в

(а, b). Тогда вероятность того, что окажется в

интервале (а',b'), равна интегралу

b'

P{a ' b '} p ( x)dx

a'

(17)

Непрерывные случайные величины

На рис. 3 заштрихованная

площадь равна значению этого

интеграла.

Множество значений может

быть любым интервалом.

Возможен даже случай а = –∞, а

также b = ∞ .

Однако плотность р(х) должна

удовлетворять двум условиям,

аналогичным (4)-(5), для

дискретных величин:

1. плотность р(х) положительна:

р(х)>0

(18)

2. интеграл от плотности р(х)

по всему интервалу (a,b) равен 1:

b

p( x)dx 1

a

(19)

Рис. 3. Плотность

вероятности

непрерывной случайной

величины

Непрерывные случайные величины

Математическим ожиданием непрерывной

случайной величины называется число

b

(20)

M ( ) xp ( x) dx

a

Смысл этой характеристики такой же, как в

случае дискретной случайной величины.

Отметим, что для любой непрерывной

случайной величины при каждом x имеем

Р{ = х} = 0.

Физический смысл имеет не вероятность

попадания в заданную точку х, а вероятность

попадания в сколь угодно малый интервал:

P{x < x+dx} = p(x)dx.

Непрерывные случайные величины

Рассмотрим пример.

Случайная величина , определенная в интервале

(0,1) и имеющая плотность р(х)=1, называется

равномерно распределенной в (0,1).

В самом деле, какой бы интервал (а’, b') внутри (0,

1) мы ни взяли, вероятность того, что попадет в (а',

b'

b'), равна

p( x)dx b ' a '

a'

т.е. длине этого интервала.

В частности, если мы разделим интервал (0,1) на

любое число интервалов равной длины, то

вероятность попадания в любой из них будет одна и

та же.

Легко вычислить, что

1

1

1

M ( ) xp( x)dx xdx

2

0

0

1

1 1 1

D( ) x p( x)dx (M )

3 4 12

0

2

2

Нормальные случайные величины

Нормальной (или гауссовской) случайной

величиной называется случайная величина ,

определенная на всей оси (- ∞, ∞) и имеющая

плотность

( x a) 2

1

p ( x)

exp

,

(21)

2

2

2

где а и > 0 — числовые параметры.

Параметр а не влияет на форму кривой у=р(х):

изменение его приводит лишь к сдвигу кривой

вдоль оси х. Однако при изменении форма

кривой меняется.

Нормальные случайные величины

В самом деле, легко видеть, что

1

max p( x) p(a)

2

Если уменьшать , то mах р(х) будет

возрастать.

Но вся площадь под кривой у = р(х) по

условию (19) равна 1. Поэтому кривая будет

вытягиваться вверх в окрестности х = а, но

убывать при всех достаточно больших

значениях х.

(22)

Нормальные случайные величины

На рис. 4 построены две

нормальные плотности,

соответствующие а = 0, = 1 и

a=0, = 0,5. Можно доказать, что

M() = a, D() = 2.

(23)

Любые вероятности вида

Р {х' < S < х"} легко вычисляются

с помощью таблицы, в которой

приведены значения функции

x

,

(24)

1

t / 2

( x)

2

e

2

dt

0

называемой интегралом

вероятностей.

Нормальные случайные

величины очень часто

встречаются при исследовании

самых различных по своей

природе вопросов.

Рис 4. Нормальные

распределения

Правило «трех сигм»

Вероятность попадания реализаций

нормально распределенной случайной

величины в интервал a 3 составляет более

99,7%:

P{a – 3 < < a + 3} = Ф(3) = 0,997.

Вероятность 0,997 настолько близка к 1, что

иногда последнюю формулу интерпретируют так:

при одном испытании практически

невозможно получить значение ,

отличающееся от M() больше, чем на 3.

Центральная предельная теорема

Эта замечательная теорема была впервые сформулирована

П.Лапласом. Обобщением этой теоремы занимались многие

выдающиеся математики, в том числе П.Л.Чебышев, А.А.Марков,

А.M.Ляпунов. Доказательство ее достаточно сложно.

Рассмотрим N одинаковых независимых

случайных величин 1, 2….n, так что распределения

вероятностей этих величин совпадают.

Следовательно, их математические ожидания и

дисперсии также совпадают (предполагается, что они

конечны). Величины эти могут быть как

непрерывными, так и дискретными.

Обозначим

M(1) = M(2) = … = M(n) = m,

M(1) = M(2) = … = M(n) = b2.

Центральная предельная теорема

Рассмотрим теперь нормальную случайную

величину с такими же параметрами:

а = Nm,

b N .

В центральной предельной теореме

утверждается, что для любого интервала (а', b')

при больших N

b'

P{a ' N b '} p N ( x)dx

(25)

a'

Физический смысл этой теоремы очевиден: сумма N

большого числа одинаковых случайных величин приближенно

нормальна.

На самом деле эта теорема справедлива при гораздо более

широких условиях: все слагаемые не обязаны быть

одинаковыми и независимыми; существенно только, чтобы

отдельные слагаемые не играли слишком большой роли в сумме.

Центральная предельная теорема

Именно эта теорема объясняет, почему

нормальные случайные величины так часто

встречаются в природе.

В самом деле, каждый раз, когда мы

сталкиваемся с суммарным воздействием

большого числа незначительных случайных

факторов, результирующая случайная величина

оказывается нормальной.

Например, отклонение артиллерийского

снаряда от цели почти всегда оказывается

нормальной случайной величиной, так как оно

зависит и от метеорологических условий на

разных участках траекторий, и от многих других

факторов.

Общая схема метода Монте-Карло

Допустим, что нам требуется вычислить

какую-то неизвестную величину т.

Попытаемся придумать такую случайную

величину , чтобы М() = m.

Пусть при этом D() = b2.

Рассмотрим N независимых случайных

величин 1, 2, ..., N, распределения которых

совпадают с распределением .

Если N достаточно велико, то согласно

центральной предельной теореме

распределение суммы N = 1 + 2 + ... + N будет

приблизительно нормальным с параметрами

a = Nm, b N .

Общая схема метода Монте-Карло

Из (25) следует, что

P{Nm 3b N N Nm 3b N } 0,997

Если мы разделим выражение, стоящее в

фигурной скобке, на N, то получим

эквивалентное неравенство, и вероятность его

останется такой же:

P{m 3b

N N N m 3b

N } 0,997

Общая схема метода Монте-Карло

Последнее соотношение перепишем в несколько

ином виде:

1

P

N

N

j m

j 1

3b

0.997

N

(26)

Это - чрезвычайно важное для метода Монте-Карло

соотношение. Оно дает нам и метод расчета т, и оценку

погрешности.

В самом деле, найдем N значений случайной

величины (все равно, находить ли один раз по одному

значению каждой из величин 1, 2, ..., n или найти N

значений величины , так как все эти случайные

величины имеют одно и то же распределение и

предполагаются независимыми). Из (26) видно, что

среднее арифметическое этих значений будет

приближенно равно т.

С большой вероятностью погрешность такого

приближения не превосходит величины 3b N .

Очевидно, эта погрешность стремится к нулю с

ростом N.

Общая схема метода Монте-Карло

На практике очень часто предпочитают

ориентироваться не на оценку сверху 3b N

,

а на вероятную ошибку, которая приближенно

равна

rN 0,6745b

N

и фактическая погрешности расчета в этом

случае равна

N

1

j m

N j 1

Прохождение нейтронов сквозь пластинку

Вероятностные законы взаимодействия

отдельной элементарной частицы (нейтрона,

фотона, мезона и др.) с веществом известны.

Обычно требуется найти макроскопические

характеристики процессов, в которых участвует

огромное количество таких частиц: плотности,

потоки и т. п.

Прохождение нейтронов сквозь пластинку

Рассмотрим простейший вариант задачи о

прохождении нейтронов сквозь пластинку.

Пусть на однородную бесконечную

пластинку толщиной h падает поток нейтронов с

энергией E0; угол падения 90°.

При столкновении с атомами вещества, из

которого состоит пластинка, нейтроны могут

упруго рассеиваться или поглощаться.

Предположим для простоты, что энергия

нейтрона при рассеянии не меняется и любое

направление «отскока» нейтрона от атома

одинаково вероятно (последнее иногда

справедливо в веществах с тяжелыми атомами).

Прохождение нейтронов сквозь пластинку

На рис. 5 изображены

различные варианты

взаимодействия нейтронов с

пластинкой:

а — нейтрон проходит

сквозь пластинку,

б — нейтрон поглощается в

пластинке,

в — нейтрон отражается

пластинкой.

Требуется вычислить

вероятность прохождения

нейтрона сквозь пластинку р+;

вероятность отражения

нейтрона пластин р- и

вероятность поглощения

нейтрона в пластинке р°.

Рис. 5. Различные случаи

«судьбы» нейтронов,

падающих на пластинку

Прохождение нейтронов сквозь пластинку

Взаимодействие нейтронов с веществом

характеризуется в рассматриваемом случае

двумя постоянными c и s, которые называются

сечением поглощения и сечением рассеяния

(индексы с и s—это первые буквы английских слов

capture -- захват и scattering -- рассеяние).

Сумма этих сечений = c + s называется

полным сечением.

Физический смысл сечений следующий:

при столкновении нейтрона с атомом вещества

вероятность поглощения равна c /, а

вероятность рассеяния равна s /.

Прохождение нейтронов сквозь пластинку

Длина свободного пробега нейтрона (т. е.

длина пути от столкновения до столкновения) —

это случайная величина. Она может принимать

любые положительные значения с плотностью

вероятностей

p(x)= e-x.

Мы можем сразу написать выражение для

средней длины свободного пробега:

<>=1/ ,

а также формулу для розыгрыша :

= –(1/)ln ,

где – случайная величина на интервале (0,1).

Прохождение нейтронов сквозь пластинку

Остается еще выяснить, как выбирать

случайное направление нейтрона после

рассеяния.

Так как задача симметрична относительно

оси х, то направление вполне определяется

одним углом между направлением скорости

нейтрона и осью Ох.

Можно доказать, что требование равной

вероятности любого направления в этом случае

равносильно требованию, чтобы косинус этого

угла = cos был равномерно распределен в

интервале (-1,1) и

=2 –1.

Схема моделирования траекторий нейтронов

Предположим, что

нейтрон испытал k-e

рассеяние внутри пластинки

в точке с абсциссой xk и

поcле этого начал двигаться

в направлении k.

Разыграем длину

свободного пробега

= –(1/)ln

и вычислим абсциссу

следующего столкновения

(рис.6)

xk+1 = xk + kk .

Схема моделирования траекторий нейтронов

Проверим условие прохождения сквозь

пластинку:

xk+1>h.

Если это условие выполнено, то счет

траектории нейтрона заканчивается и

добавляется единица к счетчику прошедших

частиц.

В противном случае проверяем условие

отражения:

xk+1<0.

Если это условие выполнено, то счет

траектории заканчивается и добавляется

единица к счетчику отраженных частиц.

Если же и это условие не выполнено,

т. е. 0 xk+1 h, то, значит, нейтрон испытал k+1-е

столкновение внутри пластинки, и надо

разыграть «судьбу» нейтрона при столкновении.

Схема моделирования траекторий нейтронов

Выбираем очередное значение и проверяем

условие поглощения:

c

Если последнее неравенство выполнено, то

счет траектории заканчивается и добавляется

единица к счетчику поглощенных частиц.

В противном случае мы считаем, что нейтрон

испытал рассеяние в точке с абсциссой xk+1.

Тогда разыгрываем новое направление скорости

нейтрона

k 1 2 1

и затем повторяем весь цикл снова (но,

конечно, уже с другими значениями ).

Схема моделирования траекторий нейтронов

Все написаны без индексов, так как имеется

в виду, что каждое значение используется всего

один раз. Для расчета одного звена траектории

нужны три значения . Начальные значения для

каждой траектории:

x0 0, 0 1

После того как будут сосчитаны N

траекторий, окажется, что N+ нейтронов прошли

сквозь пластинку, N– нейтронов отразились от

нее, а N0 нейтронов были поглощены в ней.

Схема моделирования траекторий нейтронов

Очевидно, искомые вероятности приближенно

равны отношениям:

N N 0 N0

p

,p

,p

.

N

N

N

На рис. 7 приведена блок-схема программы для

расчета этой задачи.

Индекс j — это номер траектории, индекс k —

номер столкновения (вдоль траектории).

Отметим только, что метод Монте-Карло позволяет решать

гораздо более сложные задачи об элементарных частицах:

исследуемая среда может состоять из различных веществ и

иметь любую геометрическую структуру; энергия частицы при

каждом столкновении может меняться. Можно учитывать много

других ядерных процессов (например, возможность деления

атома при столкновении с нейтроном и образование при этом

новых нейтронов). Можно рассчитать условие возникновения и

поддержания цепной реакции и т. д.

Схема моделирования

траекторий нейтронов

Рис. 7. Блок-схема

программы расчета

прохождения нейтронов в

пластине

Лекция окончена

Нажмите клавишу <ESC> для выхода