Основные этапы построения и анализа регрессионной модели.

реклама

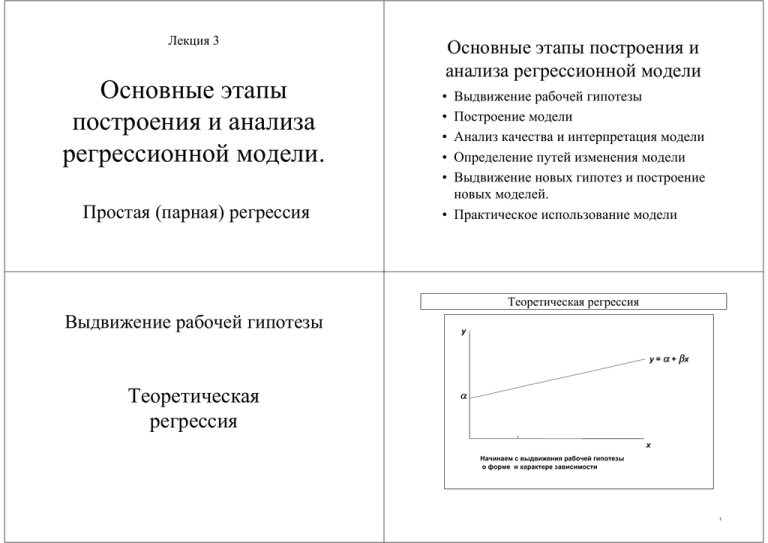

Лекция 3 Основные этапы построения и анализа регрессионной модели. Простая (парная) регрессия Основные этапы построения и анализа регрессионной модели • • • • • Выдвижение рабочей гипотезы Построение модели Анализ качества и интерпретация модели Определение путей изменения модели Выдвижение новых гипотез и построение новых моделей. • Практическое использование модели Теоретическая регрессия Выдвижение рабочей гипотезы y y = α + βx Теоретическая регрессия α x Начинаем с выдвижения рабочей гипотезы о форме и характере зависимости 1 Влияние случайного члена Построение регрессионной модели Влияние случайного члена P4 y y = α + βx P1 α Q1 x1 Q2 P2 x2 Q3 Q4 Теоретическая и расчетная регрессии P3 x3 x x4 y = α + βx + u 1 5 Наблюдаемые значения Теоретическая и расчетная регрессии P4 y P1 ^ = a + bx y P1 P2 x1 P4 y x2 P3 P2 a x3 x4 x x1 На практике мы можем наблюдать только точки P. x2 P3 x3 x4 x По этим точкам строим регрессию 7 8 Остатки y Расхождение теоретической и расчетной регрессий y (фактическое значение) y^ (расчетное значение) y-^ y = e (остаток) e4 R3 e1 R2 P1 R1 a x1 e2 P2 x2 P4 ^ = a + bx y y y (фактическое значение) y^ (расчетное значение) R4 R3 e3 P1 P3 R1 a x3 x4 P4 x x1 R4 R2 P2 x2 ^ = a + bx y y = α + βx P3 x3 x4 x Теоретическая и расчетная линии регрессии не совпадают Остатки не совпадают со значениями случайного члена Идея метода наименьших квадратов Метод наименьших квадратов: Метод наименьших квадратов Минимизировать S, где S = ∑ ei2 = e12 + ... + en2 Вид суммы квадратов остатков Вывод формул для оценки коэффициентов - 1 S = ∑ yi2 + na 2 + b 2 ∑ x i2 − 2a ∑ y1 − 2b∑ x i yi + 2ab∑ x i Метод наименьших квадратов: Минимизировать S, где ∂S = 0 ⇒ 2na − 2∑ yi + 2b∑ xi = 0 ∂a na = ∑ yi −b∑ x i S = ∑ ei2 = e12 + ... + en2 S = e12 + ... + en2 = ( y1 − a − bx1 ) 2 + ... + ( yn − a − bx n ) 2 = y12 + a 2 + b 2 x12 − 2ay1 − 2bx1 y1 + 2abx1 b 2 xn2 − 2ayn − 2bx n yn + 2abx n a = y − bx + ... + yn2 + a 2 + = ∑ yi2 + na 2 + b 2 ∑ xi2 − 2a ∑ yi − 2b∑ xi yi + 2ab∑ x i Вывод формул для оценки коэффициентов - 2 ∂S = 0 ⇒ 2b ∑ xi2 − 2 ∑ xi yi + 2a ∑ xi = 0 ∂b b ∑ xi2 − ∑ xi yi + a ∑ xi = 0 b ∑ xi2 − ∑ xi yi + ( y − bx ) ∑ xi = 0 Прямой расчет коэффициентов регрессии Расчетные формулы для коэффициентов парной регрессии b ∑ xi2 − ∑ xi yi + ( y − bx )nx = 0 b(∑ xi2 − nx 2 ) = ∑ xi yi − nxy 1 1 b ∑ xi2 − x 2 = ∑ xi yi − xy n n bVar( x ) = Cov( x , y ) Cov( x , y ) b= Var( x ) a = y − bx b= Cov( x , y ) Var( x ) Команды метода наименьших квадратов Построение парной регрессии LS Строится уравнение регрессии Практические расчеты в программе MicroTSP Формат команды: LS Y C X Y - зависимая переменная С - константа, X - независимая переменная Указание константы обязательно Примеры: LS HOUS C DPI Интерпретация коэффициента линейной регрессии Интерпретация коэффициента при объясняющей переменной yˆ = a + bx Интерпретация коэффициентов регрессии b показывает, на сколько единиц изменится y при изменении x на одну единицу-27.571 0.1787 Обязательно указание точного характера изменения (увеличение, уменьшение), конкретного числового значения и единиц измерения. Примеры: HOUS=-27,57+0,178DPI 0,178 показывает, что при росте совокупного личного располагаемого дохода на 1 млрд долларов расходы на жилье возрастают на 178 миллионов долл. Интерпретация свободного члена Интерпретация свободного члена yˆ = a + bx a показывает, на сколько единиц график регрессии смещен вверх при x=0. Экономическая интерпретация (если она допустима) - значение y при нулевом значении x. Качество уравнения регрессии (предварительное рассмотрение) Часто экономическая интерпретация отсутствует. Прежде, чем давать интерпретацию a и b, нужно убедиться в высоком качестве уравнения. Примеры: HOUS=-27,57+0,178DPI -27,57 указывает на точку пересечения оси y. Экономический смысл здесь отсутствует. Коэффициент детерминации Коэффициент детерминации R-squared Дает предварительную оценку качества модели (от 0 до 1). Показывает долю объясненной дисперсии зависимой переменной Не позволяет дать окончательного заключения без учета других факторов Отсутствуют таблицы для критических значений, для этого нужно рассчитывать на его основе другие показатели. Подвержен влиянию посторонних факторов и может привести к ошибочному выводу. Вспомогательные приемы анализа качества уравнения Возможно получение дополнительной информации о регрессии 1) Матрица ковариации 2) Картина и таблица остатков Опции P, S, G P - вывод на печать S - вывод на экран G - вывод графика остатков в режиме графического экрана Вспомогательные расчеты Встроенный калькулятор = Вызывает встроенный калькулятор Прямой доступ к данным, результатам и процедурам расчетов Арифметические действия +, -, *, /, ^ Можно использовать скобки. Допустимы дробные степени, включая квадратный корень. Примеры: Получение значения переменной Статистические функции Прямое обращение к данным Встроенные функции @FUNCTION(…) X(n-1) Вызов значения переменной по номеру наблюдения Первое наблюдение соответствует номеру 0 Примеры: HOUS(0) DPI(11) PHOUS(25)/TPE(25)*100 =2*2 =(17/2)^(1/2) Вычисляет значение указанной функции Наиболее важные функции @Cov(X,Y), @Cor(X,Y) @Var(X) @Sum(X) @Mean(X) Примеры: =@Mean(HOUS) =@Cov(X,Y)/@Var(X) Параметры модели и константы Зарезервированное имя для остатков Вектор параметров Остатки C(n) После расчета регрессии сохраняет значения коэффициентов регрессии С(1) - свободный член регрессии С(2) - коэффициент регрессии Примеры: RESID Скрытая переменная. После расчета регрессии сохраняет значения всех остатков Примеры: PLOT(A) RESID =С(1)+С(2)*100 =C(1)+С(2)*DPI(24) Генерация данных Генерация новых переменных GENR Создает новую переменную по указанному уравнению Примеры: GENR E=RESID GENR E=Y-C(1)-C(2)*X Детальное рассмотрение проблемы качества регрессионой модели Свойства оцененных уравнений и остатков Смысл коэффициента детерминации - 1 Три полезных предварительных результата Смысл коэффициента детерминации ei = yi − yˆ i _ e =0 yˆ = y ⇒ yi = yˆ i + ei Cov( yˆ , e ) = 0 Эти результаты легко доказываются, исходя из свойств средних и ковариации, а также могут быть проверены на примерах Смысл коэффициента детерминации - 2 Смысл коэффициента детерминации - 3 Смысл коэффициента детерминации Смысл коэффициента детерминации ei = yi − yˆ i ⇒ yi = yˆ i + ei ei = yi − yˆ i Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) ⇒ yi = yˆ i + ei Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) _ 1 1 1 ∑( y − y ) 2 = ∑( yˆ − yˆ ) 2 + ∑(e − e ) 2 n n n Cov( yˆ , e ) = 0 Смысл коэффициента детерминации - 4 Смысл коэффициента детерминации - 5 Смысл коэффициента детерминации Смысл коэффициента детерминации ei = yi − yˆ i ⇒ yi = yˆ i + ei ei = yi − yˆ i ⇒ yi = yˆ i + ei Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) _ 1 1 1 ∑( y − y ) 2 = ∑( yˆ − yˆ ) 2 + ∑(e − e ) 2 n n n 2 2 ∑( y − y ) = ∑( yˆ − y ) + ∑ e 2 _ 1 1 1 ∑( y − y ) 2 = ∑( yˆ − yˆ ) 2 + ∑(e − e ) 2 n n n 2 2 ∑( y − y ) = ∑( yˆ − y ) + ∑ e 2 TSS = ESS + RSS e =0 _ yˆ = y Разложение суммы квадратов остатков «Объясненная» сумма квадратов остатков Смысл коэффициента детерминации Смысл коэффициента детерминации TSS = ESS + RSS TSS = ESS + RSS TSS - Total Sum of Squares - полная сумма квадратов TSS - Total Sum of Squares - полная сумма квадратов ESS - Explained Sum of Squares - «объясненная» сумма квадратов «Остаточная» сумма квадратов остатков Коэффициент детерминации как отношение Смысл коэффициента детерминации Смысл коэффициента детерминации TSS = ESS + RSS TSS - Total Sum of Squares - полная сумма квадратов ESS - Explained Sum of Squares - «объясненная» сумма квадратов ei = yi − yˆ i ⇒ yi = yˆ i + ei Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) _ 1 1 1 ∑( y − y ) 2 = ∑( yˆ − yˆ ) 2 + ∑(e − e ) 2 n n n 2 2 ∑( y − y ) = ∑( yˆ − y ) + ∑ e 2 TSS = ESS + RSS RSS - Residual Sum of Squares - «оставшаяся» сумма квадратов ESS ∑ ( yˆ i − yˆ ) 2 R = = TSS ∑ ( yi − y ) 2 2 Интерпретация коэффициента детерминации Связь коэффициента детерминации и остатков Смысл коэффициента детерминации Смысл коэффициента детерминации ei = yi − yˆ i Var ( y ) = Var( yˆ ) + Var( e) ∑( y − y ) 2 = ∑( yˆ − y ) 2 + ∑ e 2 TSS = ESS + RSS ESS ∑ ( yˆ i − yˆ ) 2 R = = TSS ∑ ( yi − y ) 2 2 R2 показывает долю дисперсии зависимой переменной, “объясненной” (уравнением регрессии) ⇒ yi = yˆ i + ei Var( y ) = Var( yˆ + e ) = Var( yˆ ) + Var(e ) + 2Cov( yˆ , e ) = Var( yˆ ) + Var(e ) _ 1 1 1 ∑( y − y ) 2 = ∑( yˆ − yˆ ) 2 + ∑(e − e ) 2 n n n 2 2 ∑( y − y ) = ∑( yˆ − y ) + ∑ e 2 TSS = ESS + RSS 2 R2 = ∑ ei ESS ∑ ( yˆ i − yˆ ) 2 = = 1− 2 2 TSS ∑ ( yi − y ) ∑ ( yi − y ) Эквивалентность критерия детерминации и МНК - 1 2 ∑ ei ESS ∑ ( yˆ i − yˆ ) 2 R = = = 1− 2 2 TSS ∑ ( yi − y ) ∑ ( yi − y ) 2 Эквивалентность критерия детерминации и МНК - 2 2 ∑ ei ESS ∑ ( yˆ i − yˆ ) 2 R = = = 1− 2 2 TSS ∑ ( yi − y ) ∑ ( yi − y ) 2 Если R2 достигает своего наибольшего возможного значения , то одновременно минимизируется сумма квадратов остатков Эквивалентность критерия детерминации и МНК - 3 2 R2 = ∑ ei ESS ∑ ( yˆ i − yˆ ) 2 = = 1− 2 2 TSS ∑ ( yi − y ) ∑ ( yi − y ) Если R2 достигает своего наибольшего возможного значения , то одновременно минимизируется сумма квадратов остатков Критерий качества R2 эквивалентнен принципу наименьших квадратов Связь показателя R2 с коэффициентом корреляции Связь показателя R2 с коэффициентом корреляции ry , yˆ = = = Практическое использование регрессионной модели Cov( y , yˆ ) Cov([ yˆ + e ], yˆ ) = Var( y ) Var( yˆ ) Var( y ) Var( yˆ ) Cov( yˆ , yˆ ) + Cov(e , yˆ ) Var( yˆ ) = Var( y ) Var( yˆ ) Var( y ) Var( yˆ ) Var( yˆ ) Var( yˆ ) = Var( y ) Var( yˆ ) Var( yˆ ) Var( y ) • • Аналитические расчеты Прогнозирование = R2 ry , yˆ = R 2 Аналитические и прогнозные расчеты. Использование вектора коэффициентов =C(1)+C(2)*X Вычисление значения зависимой переменной по уравнению регрессии для реального или предполагаемого значения X. Примеры: =С(1)+С(2)*(DPI(24) GENR YEST=C(1)+C(2)*DPI Команды MicroTSP для расчета и анализа парной регрессии (обзор) Расчет регрессии: LS Генерация новой переменной: GENR Функции: @Sum(X), @Mean(X), @Var(X), @Cov(X,Y), @Cor(X,Y) Вектор параметров: C(1), C(2) Остатки: RESID Аналитические и прогнозные расчеты: =C(1)+C(2)*X Конец лекции