matlab 6

advertisement

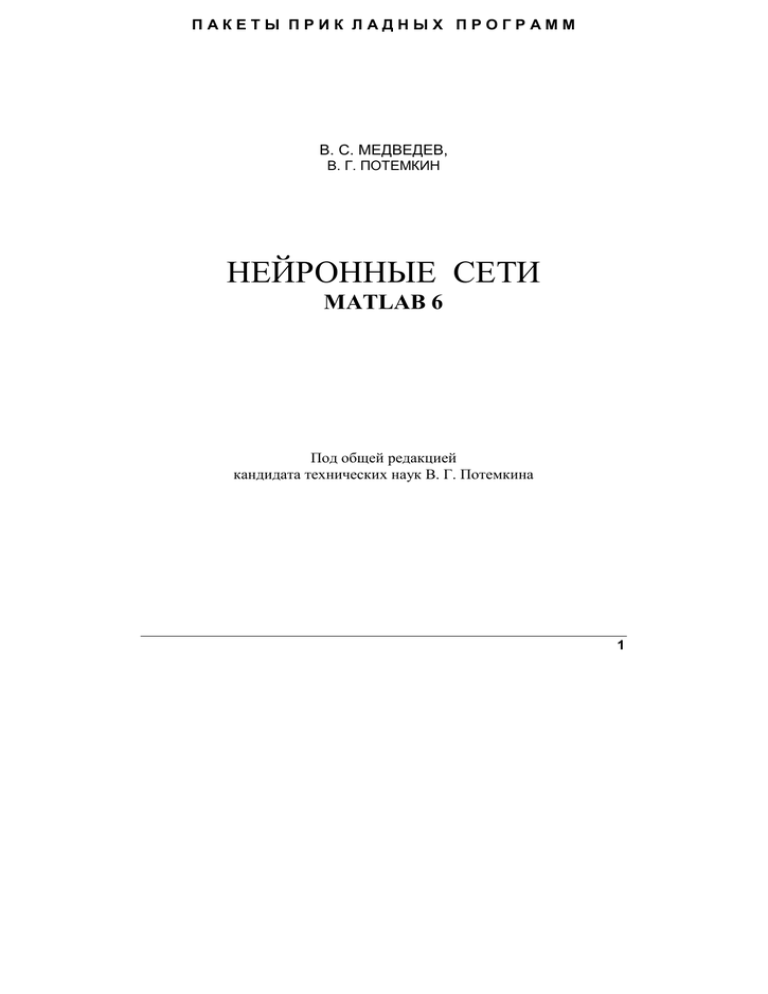

ПАКЕТЫ ПРИК ЛАДНЫХ ПРОГРАММ

В. С. МЕДВЕДЕВ,

В. Г. ПОТЕМКИН

НЕЙРОННЫЕ СЕТИ

MATLAB 6

Под общей редакцией

кандидата технических наук В. Г. Потемкина

1

УДК 681.

Пакеты прикладных программ

Выпускается с 1999 года

Медведев В. С., Потемкин В. Г.

Нейронные сети. MATLAB 6./Под общ. ред. В. Г. Потемкина. – М.: ДИАЛОГМИФИ, 2001. – 630 с. – (Пакеты прикладных программ; Кн. 4).

ISBN 5-86404-144-0 (Кн. 4)

В книге содержится описание пакета прикладных программ Neural Network Toolbox

(ППП NNT) версии 4 (выпуски 11 и 12), функционирующего под управлением ядра

системы MATLAB версий 5.3 и 6.

Книга состоит из двух частей. Первая часть содержит теорию и описание различных

типов нейронных сетей; вторая – включает справочный материал, связанный с описанием

М-функций пакета.

Рассмотрено 15 типов нейронных сетей, для каждой из которых описана архитектура,

методы адаптации, обучения и настройки параметров. Показано применение нейронных

сетей для решения прикладных задач фильтрации и предсказания сигналов, подавления

шумов, распознавания образов, построения систем управления.

Приведено полное описание вычислительной модели нейронной сети в виде массива

записей. Архитектура нейронной сети представлена ее S-моделью, которая

воспроизводится с помощью системы SIMULINK. Пакет программ дополнен библиотекой

Neural Network Toolbox Block Library, содержащей блоки, необходимые для

формирования S-модели нейронной сети.

Большое количество вспомогательных графических функций помогает пользователю

создавать наглядные проекты нейронных сетей для различных приложений.

Книга предназначена для инженеров, научных работников, аспирантов и студентов,

занимающихся созданием технических систем на основе нейронных сетей и

использующих в своей практике современные вычислительные инструменты и средства

прикладного программирования.

Учебно-справочное издание

Медведев Владимир Степанович, Потемкин Валерий Георгиевич

Нейронные сети. MATLAB 6.

Под общ. ред. В. Г. Потемкина.

ISBN 5-86404-144-0 (Кн. 4)

ISBN 5-86404-135-1

ЗАО «Диалог-МИФИ», 2001

2

© Медведев В. С., Потемкин В. Г., 2001

© Оригинал-макет, оформление обложки,

Нейронные сети. MATLAB 6

ПРЕДИСЛОВИЕ

Предлагаемая вниманию читателя книга входит в серию "Пакеты прикладных

программ". Эта серия книг [54–56] посвящена описанию прикладного программного

обеспечения фирмы MathWorks, функционирующего под управлением ядра системы

MATLAB.

Нейронные сети представляют новое направление в практике создания технических

систем. Возможности нейронных сетей выполнять операции сравнения по образцу и

классификации объектов, недоступные для традиционной математики, позволяют

создавать искусственные системы для решения задач распознавания образов, диагностики

заболеваний, автоматического анализа документов и многих других нетрадиционных

приложений.

Теория нейронных сетей развивается в течение последнего полувека, но практическое

ее применение стало возможно только в последние 10–15 лет, когда была создана

необходимая элементная база для реализации нейронных сетей. Обращаем внимание

читателей на ряд обзорных работ по нейронным сетям на русском языке [57, 58].

Тем не менее данная книга занимает особое место, поскольку в ней описан реальный

инструмент для расчета и проектирования нейронных сетей. Книга состоит из двух частей.

Часть 1 содержит теорию и описание конкретных нейронных сетей. В нее также включен

раздел по системе MATLAB 6 и GUI-интерфейсу для работы с ППП NNT. Часть 2 включает справочный материал по описанию М-функций пакета.

Значительное внимание уделено проектированию контроллеров для систем

управления на основе нейронных сетей. Рассмотрено несколько весьма сложных систем

управления, для которых процедура проектирования контроллера занимает значительное

время.

В первую очередь это модель химического реактора с непрерывным перемешиванием, где

используется модель управляемого процесса для предсказания поведения реактора в

процессе его функционирования. Другая модель – управление движущимся объектом в

магнитном поле. Здесь в качестве модели управляемого процесса используется

нелинейная авторегрессионная модель со скользящим средним, которая входит в состав

регулятора

и реализуется в виде нейронной сети. Еще один пример связан с управлением роботом,

здесь нейронные сети используются для построения как модели управляемого объекта,

так и самого регулятора. Работа с этими системами возможна только при наличии ядра

системы MATLAB версии 6 и системы Simulink версий 4 (R12) или 5.

Читателю следует выбрать стиль работы с книгой. Начинающему знакомиться

с теорией и практикой нейронных сетей рекомендуется в первую очередь просмотр

демонстрационных примеров и формирование сетей с помощью GUI-интерфейса NNTool.

Опытному пользователю, создающему собственные архитектуры нейронных сетей,

следует применять режим работы из командного окна, который позволяет

3

воспользоваться всеми возможностями ППП NNT. Следует также обратить внимание на

интерфейс ППП NNT с системой SIMULINK, что позволяет наглядно отображать

архитектуру сети и выполнять моделирование как статических, так и динамических

нейронных сетей.

При чтении книги читатель найдет большое количество примеров формирования

и расчета нейронных сетей. Все операторы в этих примерах проверены и в точности

соответствуют приводимым результатам. Таким образом, читатель, предполагающий

активно использовать компьютер при изучении материала этой книги, сможет

воспроизводить примеры в среде системы MATLAB с установленным ППП NNT. Кроме

того,

мы

предполагаем к моменту выхода книги разместить на сайте www.mathworks.ru М-файлы

этих сценариев, которые будут доступны для копирования. Это позволит избавиться

от возможных непреднамеренных ошибок пользователя.

Авторы выражают благодарность О. А. Мишулиной за полезные советы при

подготовке рукописи книги, способствовавшие ее улучшению.

В. С. Медведев,

В. Г. Потемкин,

сентябрь 2001 г.

4

Нейронные сети. MATLAB 6

ВВЕДЕНИЕ

В последние годы наблюдается повышенный интерес к нейронным сетям, которые

нашли применение в самых различных областях человеческой деятельности – бизнесе,

медицине, технике. Нейронные сети используются при решении задач прогнозирования,

классификации, управления. Такой впечатляющий успех определяется несколькими

причинами [46–49]:

Нейронные сети – это исключительно мощный метод имитации процессов и явлений,

позволяющий воспроизводить чрезвычайно сложные зависимости. Нейронные сети

по свой природе являются нелинейными, в то время как на протяжении многих лет

для построения моделей использовался линейный подход. Кроме того, во многих

случаях нейронные сети позволяют преодолеть "проклятие размерности",

обусловленное тем, что моделирование нелинейных явлений в случае большого числа

переменных требует огромного количества вычислительных ресурсов.

Другая особенность нейронных сетей связана с тем, что они используют механизм

обучения. Пользователь нейронной сети подбирает представительные данные, а затем

запускает алгоритм обучения, который автоматически настраивает параметры сети.

При этом от пользователя, конечно, требуется какой-то набор эвристических знаний

о том, как следует отбирать и подготавливать данные, выбирать нужную архитектуру

сети и интерпретировать результаты, однако уровень знаний, необходимый для

успешного применения нейронных сетей, гораздо скромнее, чем, например, при

использовании традиционных методов.

Тем не менее искусственные нейронные сети основаны на весьма простой

биологической модели нервной системы. Нервная система человека, построенная из

элементов, называемых нейронами, имеет ошеломляющую сложность. Около 1011

нейронов участвуют примерно в1015 передающих связях, имеющих длину метр и более.

Каждый нейрон обладает многими качествами, общими с другими элементами организма

человека, но его уникальной способностью является прием, обработка и передача

электрохимических сигналов по нервным путям, которые образуют коммуникационную

систему мозга.

Интенсивность сигнала, получаемого нейроном (следовательно, и возможность его

активации), сильно зависит от активности линии связи. Каждая линия связи имеет

определенную протяженность, и специальные химические вещества передают сигнал

вдоль нее. Предполагается, что обучение заключается в первую очередь в изменении

интенсивности связей. Например, в классическом опыте Павлова каждый раз

5

непосредственно перед кормлением собаки звонил колокольчик и собака быстро

научилась связывать звонок колокольчика с пищей.

Мозг, построенный из очень большого числа нейронов (каждый из которых

принимает взвешенную сумму входных сигналов и при определенных условиях имеет

возможность передавать сигнал дальше), способен решать чрезвычайно сложные задачи.

Такую же модель реализуют и искусственные нейронные сети.

Теория нейронных сетей возникла из исследований в области искусственного

интеллекта, а именно из попыток воспроизвести способность нервных биологических

систем обучаться и исправлять ошибки, моделируя низкоуровневую структуру мозга.

Основой исследований по искусственному интеллекту в 60–80-е гг. были экспертные

системы. Такие системы основывались на высокоуровневом моделировании процесса

мышления

(в частности, на представлении, что процесс нашего мышления построен на

манипуляциях с символами). Скоро стало ясно, что подобные системы, хотя и могут

принести пользу в некоторых областях, не отражают ключевых свойств человеческого

интеллекта. Согласно одной из точек зрения причина этого состоит в том, что они не в

состоянии воспроизвести структуру мозга. Чтобы создать искусственный интеллект,

необходимо построить систему с архитектурой похожей на строение мозга.

Искусственные нейронные сети также составлены из множества простых элементов,

действующих параллельно. Как и в природе, функция нейронной сети в значительной

степени определяется связями между элементами. Нейронную сеть можно обучать для

выполнения конкретной функции, регулируя значения коэффициентов (весов) связи.

Обычно искусственные нейронные сети настраиваются или обучаются так, чтобы

конкретные входы преобразовывались в заданный целевой выход. Сеть настраивается

(обучается), основываясь на сравнении сигналов выхода и цели до тех пор, пока выход

сети не будет соответствовать цели. Чтобы обучить сеть при таком управляемом

обучении, как правило, используется много пар значений сигналов вход/цель.

Нейронные сети обучаются выполнять сложные функции в различных областях

приложений, включая распознавание образов, идентификацию, классификацию объектов,

распознавание речи, системы технического зрения и системы управления. В этих случаях

применяются достаточно простые нейронные сети, но даже они оказываются мощным

инструментом в арсенале специалиста.

Сегодня могут быть построены искусственные нейронные сети для решения таких

задач, которые являются трудными как для компьютеров, построенных по традиционной

схеме, так и для человека.

Теория нейронных сетей развивается в течение последних пяти десятилетий, но

нашла широкое применение только в последние 15 лет. Поэтому строгая терминология

в области нейронных сетей еще не установилась. Этим теория нейронных сетей

6

Нейронные сети. MATLAB 6

отличается от теории управления или оптимизации, где терминология, основные

математические методы и процедуры проектирования выверены при решении

практических задач в течение многих лет.

ППП Neural Network Toolbox служит средством, которое помогает пользователям

развивать методы проектирования и расширять область применения нейронных сетей.

Поскольку данная область исследований характеризуется значительной новизной, данное

пособие описывает только основные положения теории нейронных сетей и используемые

в ней методы и процедуры, а на примерах поясняет, как применять их. Мы полагаем, что

понимание примеров и их приложений весьма существенно для успешного использования

этого ППП.

Нейронные сети нашли применение во многих областях техники, где они

используются для решения многочисленных прикладных задач:

в космонавтике и аэронавтике – для построения систем автоматического

пилотирования самолетов, имитации траекторий полета, разработки перспективных

конструкций

автопилотов, моделирования и обнаружения неисправностей агрегатов летательных

аппаратов, управления воздушным движением, обработки аэрокосмической информации;

в автомобилестроении – для проектирования автоматических систем управления;

в банковском деле – для автоматического чтения документов и их контроля, оценки

эффективности кредитных вложений;

в военном деле – для управления оружием, слежения за целями, выделения и

распознавания объектов, построения новых типов датчиков, обработки звуковых,

радиолокационных и телевизионных изображений, постановки и подавления помех,

идентификации сигналов и изображений;

в электронике – для управления процессом проектирования и размещения

микросхем на плате, нелинейного моделирования и анализа отказа микросхем, для

построения систем машинного зрения и синтеза речи;

в финансовом деле – для анализа кредитных потоков, оценки недвижимости, общего

финансового анализа, прогнозирования стоимости валюты;

в страховом деле – для определения оптимальной стратегии страхования;

в промышленном производстве – для управления производственными процессами,

анализа продукции, диагностики работы машин, контроля качества, тестирования

продукции, анализа качества сварочных работ, шлифовальных операций, анализа

и синтеза химических веществ, прогнозирования цены продукта;

Введение

7

в медицине – для анализа раковых клеток, диагностики заболеваний,

конструирования протезов, оптимизации времени трансплантации, планирования

расходов больницы, консультаций в отсутствие специалистов;

в нефтегазовой промышленности – для разведки месторождений;

в робототехнике – для управления роботами, построения контроллеров роботов

и манипуляторов и систем технического зрения;

при передаче данных – для сжатия и отображения данных, распознавания речи,

классификации гласных звуков, преобразования текста в речь, для синхронного перевода.

Этот перечень можно продолжить и далее. Широкое применение нейронных сетей,

значительные ресурсы, вкладываемые в создание программного обеспечения и

аппаратуры для реализации нейронных сетей, показывают, что имеется большая

заинтересованность в разработке искусственных нейронных сетей.

Используемые обозначения

Обозначения скаляров, векторов и матриц:

скаляры – курсивные строчные буквы: a, b, c;

векторы – прямые строчные полужирные буквы: a, b, c;

матрицы – прямые прописные полужирные буквы: A, B, C.

Обозначения весовых матриц:

весовая матрица – W(t);

элемент матрицы – wij(t), где i – номер строки, j – номер столбца, t – время или итерация;

вектор-столбец – wj(t) (вектор, соответствующий столбцу j матрицы W);

вектор-строка – wi(t) (вектор, соответствующий строке i матрицы W);

вектор смещений – b(t);

элемент вектора смещений – bi(t).

Обозначения для слоев нейронной сети:

верхний индекс из одного символа применяется для того, чтобы указать

принадлежность некоторого элемента слою. Например, вектор входа слоя 3 обозначается

как p3;

верхний индекс из двух символов применяется для того, чтобы указать источник

сигнала (l) и пункт назначения (k); он используется для обозначения матриц весов входа

IWk,l и матриц весов слоя LWk,l. Например, матрица весов от слоя 2 к слою 4 будет

обозначаться как LW42.

8

Нейронные сети. MATLAB 6

Пример структурной схемы нейронной сети:

На рисунке приведены обозначения, используемые при изображении структурных

схем нейронных сетей.

Связь математических обозначений с обозначениями, принятыми в алгоритмах и

программах ППП. При переходе от математических обозначений к кодам системы

MATLAB следует руководствоваться следующими правилами:

верхние индексы соответствуют индексам массива ячеек: p1 p{1};

нижние индексы соответствуют индексам массива чисел: p2 p(2), p12 p{1}(2);

индекс в круглых скобках соответствует второму индексу массива ячеек: p1(k) p{1, k}.

Введение

9

Часть 1. ППП NEURAL NETWORK TOOLBOX

1. СИСТЕМА MATLAB 6

Семейство программных продуктов MATLAB 6 поставляется на двух компакт-дисках,

и в соответствии с инструкцией пользователь должен инсталлировать те программные

продукты, которые необходимы для последующей работы. Требования, предъявляемые

к ресурсам персонального компьютера, следующие:

рекомендуемые процессоры – Pentium, Pentium Pro, Pentium II, Pentium III или AMD

Athlon;

операционные системы Microsoft Windows 95, Windows 98, Windows NT 4.0 с пакетом

Service Pack 5 или Windows 2000;

устройство CD-ROM для выполнения инсталляции;

требования к оперативной памяти – минимум 64 M для Windows 95, 98, NT 4.0

и 2000, крайне рекомендуется использовать 128 M, поскольку потери в

производительности при 64 M составляют около 40 %;

объем требуемого пространства памяти на диске зависит в основном от размеров

используемой справочной системы, рекомендуется не менее 4 Г;

рекомендуется применять 8-битовый графический адаптер и дисплей с палитрой

не менее 256 цветов.

Далее предполагается, что необходимая установка выполнена и вы готовы к сеансу

работы в среде MATLAB 6.

1.1. Операционная среда MATLAB 6

Работа с системой MATLAB начинается с того, что вы запускаете систему с иконки

рабочего стола системы Windows. В результате на дисплее открывается рабочий стол

системы (рис. 1.1).

Он содержит элементы графического интерфейса пользователя, которые

предназначены для работы с файлами, переменными и приложениями, связанными с

MATLAB.

На рис. 1.1 вы видите три открытых окна: командное окно Command Window, в котором

расположена командная строка, окно (панель) запуска приложений Launch Pad с

кнопками развертки/свертки и окно предыстории вызовов Command History.

Кроме того, имеются клавиши для переключения окна запуска Launch Pad на окно

рабочей области Workspace и окна предыстории Command History на окно текущего

каталога Current Directory. Здесь же показан вертикальный разделитель окон,

перемещение которого управляет размещением окон в поле экрана. Отметим также

информационное окно текущего каталога на инструментальной панели рабочего стола, а

также кнопки вызова подсказки, закрытия и отделения командного окна от рабочего

9

стола. Последняя кнопка позволяет перейти в режим работы предшествующих версий

системы MATLAB.

Рис. 1.1

Описанный рабочий стол появляется по умолчанию при запуске системы MATLAB 6.

Вы можете изменить состав и размещение рабочих окон, открывая новые, закрывая

имеющиеся, а также изменяя их размеры с помощью вертикальных и горизонтальных

разделителей. Кроме того, можно отделять окна от рабочего стола и помещать их на

рабочий стол, используя меню View инструментальной панели.

Для настройки таких параметров рабочего стола, как тип и размер шрифта, цвета

символов командной строки, следует воспользоваться опцией Preferences меню File

(рис. 1.2).

10

Нейронные сети. MATLAB 6

Рис. 1.2

Командное окно

Командное окно Command Window показано на рис. 1.3 и предназначено для работы

с переменными, файлами и функциями системы MATLAB.

Рис. 1.3

В отличие от предшествующих версий в среде системы MATLAB 6 все операторы как

в зоне просмотра командного окна, так и в командной строке могут быть активизированы

с помощью правой кнопки мыши. При этом появляется контекстное меню со следующими

опциями: Evaluate Selection (Вычислить выделенное), Open Selection (Открыть выделенное),

Help on Selection (Справка по выделенному), Copy (Копировать), Paste (Вставить).

Окно предыстории

Окно предыстории вызова операторов Command History показано на рис. 1.4. Оно

содержит строки операторов, которые вводились в командном окне с начала сеанса

работы.

1. Система MATLAB 6

11

Рис. 1.4

Эти строки можно активизировать к выполнению двойным щелчком левой кнопки

мыши, можно переносить из окна на командную строку, а можно использовать правую

кнопку мыши. При этом появляется контекстное меню со следующими опциями:

Copy (Копировать), Evaluate Selection (Вычислить выделенное), Create M-File (Создать

М-файл), Delete Selection (Удалить выделенное), Delete to Selection (Удалить до выделенного), Delete Entire History (Удалить всю предысторию).

Окно запуска

Окно, или панель запуска, Launch Pad показано на рис. 1.5 и предназначено для вызова

программных продуктов, включенных в состав инсталлированной версии системы MATLAB.

12

Нейронные сети. MATLAB 6

Рис. 1.5

Активизация кнопки вызова подменю для каждого из продуктов позволяет обратиться

к средству подсказки Help, демонстрационным примерам Demos. Применительно к ядру

системы MATLAB можно активизировать либо окно текущего каталога Current Directory,

либо окно рабочей области Workspace, либо средство управления путями доступа Path.

Можно также вызвать средство построения графического интерфейса пользователя

GUIDE (GUI Builder), обратиться через Интернет к странице Product Page (Web) на сайте

фирмы The MathWorks Inc., где приведено описание продуктов семейства MATLAB.

И вновь доступно контекстное меню со следующими опциями: Open (Открыть), Edit

Source (Отредактировать источник), Refresh (Обновить).

Окно текущего каталога

Окно для просмотра текущего каталога Current Directory показано на рис. 1.6; оно

позволяет открывать, просматривать и выполнять поиск информации в файлах системы

MATLAB, имеющих необходимое расширение.

1. Система MATLAB 6

13

Рис. 1.6

Контекстное меню, связанное с правой кнопкой мыши, позволяет реализовать

следующие действия: Open (Открыть), Run (Выполнить), View Help (Просмотреть

справку), Open as Text (Открыть как текст), Import Data… (Импортировать данные…),

New

(Открыть новый... ), Rename (Переименовать), Delete (Удалить), Cut (Вырезать), Copy

(Копировать), Paste (Вставить), File Filter (Задать список расширений), Add to Path

(Добавить к пути доступа), Refresh (Обновить).

На инструментальной панели системы MATLAB 6 имеется информационное окно

Current Directory, с помощью которого всегда обеспечивается доступ к списку ранее

вызванных текущих каталогов, как это показано на рис. 1.7. Это позволяет быстро

переходить от одного каталога к другому, получая доступ к интересующим файлам.

14

Нейронные сети. MATLAB 6

Рис. 1.7

Окно рабочей области

Окно рабочей области Workspace показано на рис. 1.8 и содержит список переменных

(именованные массивы), накопленных в памяти в процессе работы, расширение списка

переменных при обращении к функциям, выполнении М-файлов и загрузке сохраненных

переменных.

Рис. 1.8

На рис. 1.8 показан список переменных, охватывающий все типы данных: это

массивы действительных и комплексных (complex) чисел удвоенной точности double

array, разновидности этих массивов, описываемые глобальной переменной global и

переменными логического типа logical. Кроме того, список содержит массив строк char

array, массив разреженной матрицы sparse array, массив записей struct array, массив ячеек

1. Система MATLAB 6

15

cell

array,

а также специальные типы целочисленных массивов uint8 и uint32 и объект типа inline

object. Для каждой переменной указывается размер массива Size, объем памяти Bytes

и тип массива Class.

Окно рабочей области, как и все окна рабочего стола системы MATLAB 6,

сопровождается контекстным меню, которое включает следующие опции: Open

Selection… (Открыть выделенное…), Graph Selection (Построить график), Select All

(Выделить все), Import Data (Импорт данных), Save Selection As… (Сохранить

выделенное как…), Save Workspace As… (Сохранить рабочую область как…), Delete Selection (Удалить выделенное), Delete Workspace (Удалить рабочую область).

На рис. 1.9 показана глубина вложенности опции Graph Selection, что позволяет в

режиме контекста строить любые типы графиков. Это определяет совершенно новый

стиль работы в среде системы MATLAB 6, когда многие предварительные действия

вообще

не требуют обращения к командной строке и могут быть реализованы с использованием

только правой кнопки мыши.

Рис. 1.9

После завершения сеанса работы данные в рабочей области не сохраняются, и

пользователь должен предусмотреть их сохранение в виде файла данных. Это реализуется

либо

с помощью опции контекстного меню Save Workspace As…, либо с помощью этой же

опции из меню File, либо с использованием команды save. Любая из этих операций

приводит к созданию специального двоичного файла с расширением .mat. Чтобы

прочитать МАТ-файл и разместить его в рабочей области, следует воспользоваться

опцией Import Data… или использовать команду load.

Окно рабочей области помимо перечисленных функций выполняет функции

обозревателя (средства просмотра) данных. Достаточно выполнить двойной щелчок по

левой клавише мыши, чтобы вызвать редактор данных Array Editor.

16

Нейронные сети. MATLAB 6

На рис. 1.10 показан редактор данных, который позволяет в интерактивном режиме

просматривать и корректировать одномерные и двумерные числовые массивы, массивы

строк и массивы строковых ячеек.

Рис. 1.10

Справочная подсистема

В состав системы MATLAB 6 входит чрезвычайно мощная подсистема справки Help.

Объем документации, к которой организуется доступ, составляет более 250 М и

поставляется на отдельном компакт-диске. Обеспечивается доступ не только к встроенной

системе Help, но и к документам в формате HTML, а также к полнотекстовым документам

в формате PDF.

Рис. 1.11

1. Система MATLAB 6

17

Экран справочной системы делится на 2 области: область навигатора Help Navigator,

где пользователь может указать интересующую его тему, термин или функцию,

относящиеся к продуктам семейства MATLAB, и область для просмотра найденной

информации. Остановимся подробнее на описании этих областей.

Навигатор справочной системы позволяет установить в поле Product Filter меру

использования источников информации: в полном (All) или ограниченном объеме (Selected). С помощью кнопки Contents tab вывести заголовки и оглавления документов; с

помощью кнопки Index tab вывести на экран индексный указатель, а с помощью кнопки

Search tab обратиться к поисковой системе. Наконец, кнопка Favorites tab позволяет

просмотреть и изменить список справочных документов, определенных в качестве

первоочередных для просмотра.

Как только требуемая информация найдена, она выводится в окно просмотра. При

этом обеспечивается возможность перехода к другим страницам, используя стрелки

в верхней и нижней частях страницы или клавиши "вперед" и "назад" инструментальной

панели этого окна. Здесь же вы можете увидеть кнопку вывода на печать содержимого

страницы, а также окно для поиска Find in page, окно с названием документа-источника,

а также кнопку создания закладки Add to Favorites.

Рис. 1.12

И вновь, как это свойственно среде MATLAB 6, пользователь имеет доступ к

контекстному меню со следующими опциями: Evaluate Selection (Вычислить

выделенное), Open Selection (Открыть выделенное), Help on Selection (Справка о

выделенном), Back (Назад), Forward (Вперед), Reload (Перезагрузить раздел), Copy

(Копировать).

18

Нейронные сети. MATLAB 6

1.2. GUI-интерфейс для ППП NNT

Отличительной особенностью 12-го выпуска программных продуктов фирмы MathWorks является включение в их состав различных инструментальных средств организации

диалога с пользователем. Как правило, это GUI-интерфейсы. Не является исключением

и пакет по нейронным сетям ППП NNT, в состав которого входит инструментальное

средство NNTool. Этот графический интерфейс позволяет, не обращаясь к командному

окну системы MATLAB, выполнять создание, обучение, моделирование, а также импорт

и экспорт нейронных сетей и данных, используя только инструментальные возможности

GUI-интерфейса. Конечно, такие инструменты наиболее эффективны лишь на начальной

стадии работы с пакетом, поскольку имеют определенные ограничения. В частности,

интерфейс NNTool допускает работу только с простейшими однослойными и

двухслойными нейронными сетями, но при этом пользователь выигрывает во времени и

эффективности освоения новых объектов.

Вызов GUI-интерфейса NNTool возможен либо командой nntool из командной строки,

либо из окна запуска приложений Launch Pad с помощью опции NNTool из раздела Neural

Network Toolbox. После вызова на экране терминала появляется окно Network/Data Manager (Управление сетью/данными) (рис. 1.13)

Рис. 1.13

Здесь:

Help – кнопка вызова окна подсказки Network/Data Manager Help (рис. 1.14);

New Data… – кнопка вызова окна формирования данных Create New Data (рис. 1.15);

1. Система MATLAB 6

19

New Network… – кнопка вызова окна создания новой нейронной сети Create New

Network (рис. 1.16);

Import…– кнопка вызова окна для импорта или загрузки данных Import or Load

to Network/Data Manager (рис. 1.17);

Export… – кнопка вызова окна для экспорта или записи данных в файл Export or

Save from Network/Data Manager (рис. 1.18).

Кнопки View, Delete становятся активными только после создания и активизации

данных, относящихся к последовательностям входа, цели, выхода или ошибок сети.

Кнопка View позволяет просмотреть, а кнопка Delete удалить активизированные данные.

Кнопки View, Delete, Initialize…, Simulate…, Train…, Adapt… становятся

активными после создания и активизации самой нейронной сети. Они позволяют

просмотреть, удалить, инициализировать, промоделировать, обучить или адаптировать

нейронную сеть и будут описаны ниже.

Прежде всего рассмотрим назначение и способы работы с перечисленными выше

окнами.

Окно Network/Data Manager Help. Это окно подсказки показано на рис. 1.14 и

описывает правила работы с диспетчером Network/Data Manager при создании

нейронной сети.

Рис. 1.14

Чтобы создать нейронную сеть, необходимо выполнить следующие операции:

20

Нейронные сети. MATLAB 6

Сформировать последовательности входов и целей (кнопка New Data), либо загрузить

их из рабочей области системы MATLAB или из файла (кнопка Import).

Создать новую нейронную сеть (кнопка New Network), либо загрузить ее из рабочей

области системы MATLAB или из файла (кнопка Import).

Выбрать тип нейронной сети и нажать кнопку Train…, чтобы открыть окно для

задания параметров процедуры обучения.

Открыть окно Network для просмотра, инициализации, моделирования, обучения

и адаптации сети.

Окно Create New Data. Это окно показано на рис. 1.15 и включает 2 области

редактирования текста для записи имени вводимых данных (область Name) и ввода самих

данных (область Value), а также 6 кнопок для указания типа вводимых данных.

Рис. 1.15

Различают следующие типы данных:

Inputs (Входы) – последовательность значений входов;

Targets (Цели) – последовательность значений цели;

Input Delay States (Состояния ЛЗ входа) – начальные условия линии задержки на входе;

Layer Delay States (Состояния ЛЗ слоя) – начальные условия линии задержки в слое;

Outputs (Выходы) – последовательность значений выхода сети;

Errors (Ошибки) – разность значений целей и выходов.

Как правило, пользователь задает только последовательности входа и цели, т. е. типы

данных Inputs и Targets. При этом следует помнить, что при адаптации нейронной сети

данные должны быть представлены в виде массива ячеек.

Окно Create New Network. Это окно показано на рис. 1.16 и включает поля для

задания параметров создаваемой сети. В зависимости от типа сети количество полей и их

названия изменяются.

1. Система MATLAB 6

21

Рис. 1.16

Обратимся к описанию полей.

Network Name (Имя сети) – стандартное имя сети, присваиваемое GUI-интерфейсом

NNTool; в процессе создания новых сетей порядковый номер будет изменяться автоматически.

Network Type (Тип сети) – список сетей, доступных для работы с интерфейсом

NNTool. Для удобства этот список повторен в нижеследующей таблице. Интерфейс

NNTool позволяет создавать нейронные сети только с одним или двумя слоями.

№ п/п

Competitive

Cascade-forward

backprop

3

Elman backprop

4

Feed-forward

backprop

5

Time delay

backprop

6

Generalized

regression

Hopfield

Linear layer

(design)

Linear layer (train)

7

8

9

22

Тип сети

1

2

Название сети

Число слоев

Обучаемые параметры

Конкурирующая сеть

Каскадная сеть с прямым

распространением сигнала

и обратным распространением ошибки

Сеть Элмана с обратным

распространением ошибки

1

2

IW{1, 1}, b{1}

IW{1, 1}, b{1},

LW{2, 1},

IW{2, 1}, b{2}

2

Сеть с прямым распространением сигнала и обратным

распространением ошибки

Сеть с запаздыванием

и обратным распространением ошибки

Обобщенная

регрессионная сеть

Сеть Хопфилда

Линейный слой (создание)

2

IW{1, 1}, b{1},

LW{2, 1}, b{2},

LW{1, 1}

IW{1, 1}, b{1},

LW{2, 1}, b{2}

Линейный слой (обучение)

2

IW{1, 1}, b{1},

LW{2, 1}, b{2}

2

1

1

IW{1, 1}, b{1},

LW{2, 1}

LW{1, 1}, b{1}

IW{1, 1}, b{1}

1

IW{1, 1}, b{1}

Нейронные сети. MATLAB 6

10

LVQ

11

12

Perceptron

Probabalistic

13

Radial basis

(exact fit)

Radial basis

(fewer neurons)

14

15

Self-organizing

map

Сеть для классификации

входных векторов

Персептрон

Вероятностная сеть

2

IW{1, 1}, LW{2, 1}

1

2

Радиальная базисная сеть

с нулевой ошибкой

Радиальная базисная сеть

с минимальным числом

нейронов

Самоорганизующаяся

карта Кохонена

2

IW{1, 1}, b{1}

IW{1, 1}, b{1},

LW{2, 1}

IW{1, 1}, b{1},

LW{2, 1}

IW{1, 1}, b{1},

LW{2, 1}, b{2}

2

1

IW{1, 1}

Примечания:

Для сетей 2, 3, 7 в данной версии интерфейса NNTool не обеспечивается просмотр

структурных схем.

Сети 5, 9 допускают введение линий задержек на входе.

Сети 3 допускают введение линий задержек в слое.

Сети с двумя слоями имеют последовательную структуру, когда выход первого слоя

служит входом второго слоя. Исключение составляют сети 3, которые допускают наличие

обратной связи в первом слое и передачу входного сигнала на входы обоих слоев.

Продолжим описание полей.

Input ranges (Диапазоны входа) – допустимые границы входов, которые либо

назначаются пользователем, либо определяются автоматически по имени входной

последовательности, выбираемой из списка Get from Inp… .

Training function (Функция обучения) – список обучающих функций.

Adaption learning function (Функции настройки для режима адаптации) – список

функций настроек.

Performance function (Функция качества обучения) – список функций оценки

качества обучения.

Number of layers (Количество слоев) – количество слоев нейронной сети.

Properties for (Свойства) – список слоев: Layer 1 (Слой 1), Layer 2 (Слой 2).

Number of neurons (Количество нейронов) – количество нейронов в слое.

Transfer function (Функция активации) – функция активации слоя.

Окно Import or Load to Network/Data Manager. Это окно показано на рис. 1.17

и включает 3 поля.

1. Система MATLAB 6

23

Рис. 1.17

Source (Источник) – поле для выбора источника данных. Это либо рабочая область

системы MATLAB (кнопка выбора Import from MATLAB Workspace), либо файл (кнопка

выбора Load from disk file).

Если выбрана первая кнопка, то в поле Select a Variable вы можете видеть все

переменные рабочей области и, выбрав одну из них, например Р1, можете определить ее в

поле Destination (Назначение) как последовательность входа Inputs (Входы).

Если выбирается кнопка Load from disk file, то активизируется поле MAT-file Name

и кнопка Browse, что позволяет начать поиск и загрузку файла из файловой системы.

Окно Export or Save from Network/Data Manager. Это окно показано на рис. 1.18

и позволяет передать данные из рабочей области GUI-интерфейса NNTool в рабочую

область системы MATLAB или записать их в виде файла на диске.

Рис. 1.18

24

Нейронные сети. MATLAB 6

В данном случае нами выбрана переменная network1, которая принадлежит к классу

network object и описывает нейронную сеть. После того как эта переменная

экспортирована в рабочую область, можно, например, построить модель нейронной сети в

системе Simulink с помощью оператора gensim.

Диалоговая панель Network показана на рис. 1.19.

Рис. 1.19

Она открывается только в том случае, когда в окне Network/Data Manager выделена

созданная сеть и становятся активными кнопки View, Initialize, Simulate, Train, Adapt.

Панель имеет 6 закладок:

View (Просмотреть) – структура сети;

Initialize (Инициализация) – задание начальных весов и смещений;

Simulate (Моделирование) – моделирование сети;

Train (Обучение) – обучение сети;

Adapt (Адаптация) – адаптация и настройка параметров сети;

Weights (Веса) – просмотр установленных весов и смещений.

Особенности работы с соответствующими окнами будут рассмотрены на

приведенных ниже примерах создания конкретных нейронных сетей.

Пример. Нейронная сеть с прямой передачей сигнала.

Создать и обучить нейронную сеть выполнению операции y = x12 + x2, если заданы

последовательности входа P = [1 0.5 0 1; –2 0 0.5 1] и цели T = [–1 0.25 0.5 2].

Сформируем последовательности входов и целей в рабочей области GUI-интерфейса

NNTool, используя окно Create New Data.

Выберем нейронную сеть типа feed-forward backprop с прямой передачей сигнала

и с обратным распространением ошибки. Схема этой сети показана на рис. 1.19.

Выполним инициализацию сети, для чего выберем закладку Initialize, откроется

диалоговая панель, показанная на рис. 1.20. Диапазоны значений исходных данных

выберем по входам из ниспадающего меню Get from input. Для ввода установленных

диапазонов и инициализации весов надо воспользоваться кнопками Set Ranges

1. Система MATLAB 6

25

(Установить диапазоны) и Initialize Weights (Инициализировать веса). Если требуется

вернуться к прежним диапазонам, то следует выбрать кнопки Revert Ranges (Вернуть

диапазоны) и Revert Weights (Вернуть веса).

Рис. 1.20

Затем выполняется обучение сети, для чего выбирается закладка Train и открывается

диалоговая панель, показанная на рис. 1.21.

Рис. 1.21

Панель имеет три закладки:

Training Info (Информация об обучающих последовательностях) (рис. 1.21);

26

Нейронные сети. MATLAB 6

Training Parametrs (Параметры обучения) (рис. 1.22);

Optional Info (Дополнительная информация) (рис. 1.23).

Рис. 1.22

Последняя закладка применяется, когда в процессе обучения используются

контрольные и тестовые последовательности.

Рис. 1.23

Применяя эти закладки, можно установить имена последовательностей входа и цели,

а также параметров процедуры обучения.

Теперь можно приступить к обучению сети (кнопка Train Network).

1. Система MATLAB 6

27

Рис. 1.24

Качество обучения сети с прямой передачей сигнала на выбранной обучающей

последовательности поясняется на рис. 1.24. Практически нулевая точность достигается

за 13 циклов обучения.

Соответствующие веса и смещения можно увидеть, если выбрать закладку Weights

(рис. 1.25).

Рис. 1.25

Для удобства работы можно экспортировать созданную нейронную сеть в рабочую

область системы MATLAB и получить информацию о весах и смещениях

непосредственно в рабочем окне системы:

network1.IW{1, 1}, network1.b{1}

ans =

–1.9390

–2.2747

ans =

1.1389

network1.LW{2, 1}, network1.b{2}

ans =

–1.5040

ans =

0.5024

28

Нейронные сети. MATLAB 6

Результаты обучения можно просмотреть в окне Network/Data Manager, выбрав

кнопку Manager (рис. 1.25). Появляется окно (рис. 1.26); теперь, активизируя имена

последовательностей выхода или ошибок network1_outputs и network1_errors, можно просмотреть результаты, используя кнопку View. Получаем выходные данные, практически

равные целям, и ошибки порядка 10-14.

Рис. 1.26

Пример. Классификация входных векторов.

Создать нейронную сеть в виде персептрона, который разделяет векторы входа на два

класса. Обозначим эти классы как 0 и 1. Обучающую последовательность сформируем

в виде двух массивов ячеек: массива входов Р = {[2; 2] [1; 2] [–2; 2] [–1; 1] [1; –2]} и

массива целей Т = {0 0 1 1 1}, который задает принадлежность каждого вектора входа

к определенному классу. Выполним эту операцию в рабочей области системы MATLAB,

а затем импортируем их в рабочую область интерфейса NNTool.

Зададим персептрон с одним нейроном, функцией активации HARDLIM и правилом

настройки LEARNP. Для этого из списка нейронных сетей выберем тип сети Perceptron

(рис. 1.27) и зададим требуемые параметры.

1. Система MATLAB 6

29

Рис. 1.27

Чтобы увидеть структурную схему сети, воспользуемся кнопкой View (рис. 1.28).

Рис. 1.28

Теперь выполним инициализацию сети, используя закладку Initialize, а затем

адаптацию и настройку параметров сети, используя закладку Adapt окна Network. Для

этого следует указать имена входа и цели, а также задать количество циклов адаптации (в

данном случае достаточно трех циклов) и нажать кнопку Adapt Network.

В результате настройки будут установлены следующие значения весов и смещений,

которые можно увидеть, выбрав закладку Weights. Для данной сети вектор весов равен

IW{1, 1} = [–3 –2], а смещение b{1} = 1. Таким образом, линия переключения,

разделяющая плоскость на 2 области, описывается следующим образом:

L: –3p1 – 2p2 + 1 = 0.

Перейдя в окно Network/Data Manager, можно просмотреть значения сигналов

на выходе и ошибку сети (рис. 1.29, а и б соответственно). Нетрудно убедиться, что на

обучающей последовательности сеть обучена точно классифицировать входные векторы.

30

Нейронные сети. MATLAB 6

а

б

Рис. 1.29

Пример динамической линейной сети:

Спроектировать динамическую линейную нейронную сеть для предсказания

синусоидальной функции по четырем предшествующим значениям.

Архитектура сети: линейная нейронная сеть с линией задержки по входу на 4 такта,

с одним входом, значения которого заключены в диапазоне [–1 1], и одним выходом.

Обучающая последовательность:

входная последовательность

time = 0:0.1:10;

P = sin(time);

последовательность целей

T = P;

Поскольку предполагается адаптивная настройка параметров сети, то обучающая

последовательность должна быть представлена в виде массива ячеек

P = con2seq(P);

T = P;

Целесообразно сформировать эти последовательности в рабочей области системы

MATLAB, а затем импортировать их в рабочую область интерфейса NNTool.

Затем выберем сеть типа Linear layer (train) с линией задержки по входу (рис. 1.30),

инициализируем ее, установим начальные значения весов, выполним адаптацию сети,

предварительно установив имена последовательностей входа и цели, а также указав

количество циклов адаптации – 250.

1. Система MATLAB 6

31

Рис. 1.30

По окончании проектирования экспортируем нейронную сеть в рабочую область

системы MATLAB.

Теперь можно построить модель нейронной сети в системе Simulink и построить ее

схему (рис. 1.31):

gensim(network1)

Рис. 1.31

Эта схема в отличие от иллюстративных схем на рис. 1.19 и 1.29 является в полной

мере функциональной схемой и может быть применена для моделирования нейронной

сети.

Используя описание нейронной сети, можно просмотреть веса и смещение в рабочем

окне системы MATLAB:

IW = network1.IW{1,1}

IW =

0.8135

0.4798

b = network1.b{1}

b =

0.0024

0.1716

–0.1143

–0.3858

Извлечем информацию об ошибке сети и построим соответствующий график

(рис. 1.32). Обратите внимание на специальную форму применения оператора cat, которая

позволяет преобразовать массив числовых ячеек в числовой массив.

32

Нейронные сети. MATLAB 6

E = cat(2,network1_errors{:});

plot(time(10:101), E(10:101))

Рис. 1.32

Из анализа рисунка следует, что погрешность обучения не превышает 0.01.

Знакомство с возможностями графического интерфейса NNTool позволяет сделать

вывод, что это средство может быть весьма полезным на начальной стадии изучения

и сравнительного анализа нейронных сетей.

1.3. Демонстрационные примеры ППП NNT

Перечень всех демонстрационных примеров, включенных в ППП NNT, можно

получить по команде help nndemos.

Персептроны

demop1

demop4

demop5

demop6

Классификация с использованием персептрона с двумя входами

Формирование входных векторов внешнего слоя

Обучение с использованием нормированной функции настройки

Пример линейно неразделимых векторов

Линейные сети

demolin1

demolin2

demolin4

demolin5

demolin6

demolin7

demolin8

Пример функционирования линейной сети

Обучение линейного нейрона

Задача линейной аппроксимации

Задача с неполными данными

Задача с линейно зависимыми данными

Оценка влияния параметра скорости настройки

Адаптируемый линейный слой

Радиальные базисные сети

demorb1

demorb3

demorb4

1. Система MATLAB 6

Радиальные базисные сети

Пример неперекрывающихся функций активации

Пример перекрывающихся функций активации

33

demogrn1

demopnn1

Сеть GRNN и аппроксимация функций

Сеть PNN и классификация векторов

Сети кластеризации и классификации данных

Самоорганизующиеся сети

democ1

demosm1

demosm2

Настройка слоя Кохонена

Одномерная карта Кохонена

Двумерная карта Кохонена

LVQ-сети

demolvq1

Классификация векторов

Рекуррентные сети

Сети Элмана

appelm1

Сеть Элмана

Сети Хопфилда

demohop1

demohop2

demohop3

demohop4

Пример двумерной модифицированной сети Хопфилда

Пример неустойчивой точки равновесия

Пример трехмерной модифицированной сети Хопфилда

Пример устойчивых паразитных точек равновесия

Применение нейронных сетей

applin1

applin2

appelm1

appcr1

Предсказание стационарного сигнала

Предсказание нестационарного сигнала

Детектирование амплитуды с помощью сети Элмана

Распознавание символов

Нейронные сети и системы управления (среда Simulink)

predcstr

narmamaglev

mrefrobotarm

Управление каталитическим реактором

Управление магнитной подушкой

Управление звеном робота

Все демонстрационные примеры описаны в тексте книги.

34

Нейронные сети. MATLAB 6

2. МОДЕЛЬ НЕЙРОНА И АРХИТЕКТУРА СЕТИ

2.1. Модель нейрона

2.1.1. Простой нейрон

Элементарной ячейкой нейронной сети является нейрон. Структура нейрона с

единственным скалярным входом показана на рис. 2.1, а.

а

Рис. 2.1

б

Скалярный входной сигнал p умножается на скалярный весовой коэффициент w, и

результирующий взвешенный вход w*p является аргументом функции активации нейрона

f, которая порождает скалярный выход a.

Нейрон, показанный на рис. 2.1, б, дополнен скалярным смещением b. Смещение

суммируется со взвешенным входом w*p и приводит к сдвигу аргумента функции f

на величину b. Действие смещения можно свести к схеме взвешивания, если представить,

что нейрон имеет второй входной сигнал со значением, равным 1. Вход n функции

активации нейрона по-прежнему остается скалярным и равным сумме взвешенного входа

и смещения b. Эта сумма является аргументом функции активации f; выходом функции

активации является сигнал a. Константы w и b являются скалярными параметрами

нейрона. Основной принцип работы нейронной сети состоит в настройке параметров

нейрона таким образом, чтобы поведение сети соответствовало некоторому желаемому

поведению. Регулируя веса или параметры смещения, можно обучить сеть выполнять

конкретную работу; возможно также, что сеть сама будет корректировать свои

параметры, чтобы достичь требуемого результата.

Уравнение нейрона со смещением имеет вид

a f (w * p b *1) .

(2.1)

Как уже отмечалось, смещение b – настраиваемый скалярный параметр нейрона,

который не является входом, а константа 1, которая управляет смещением,

рассматривается, как вход и может быть учтена в виде линейной комбинации векторов

входа

33

p

a w b .

1

(2.2)

2.1.2. Функция активации

Функции активации (передаточные функции) нейрона могут иметь самый различный

вид. Функция активации f, как правило, принадлежит к классу сигмоидальных1 функций

с аргументом n и выходом a.

Рассмотрим три наиболее распространенные формы функции активации.

Единичная функция активации с жестким ограничениям hardlim. Эта функция

описывается соотношением a = hardlim(n) = 1(n) и показана на рис. 2.2. Она равна 0, если

n < 0, и 1, если n 0.

a

1

n

-5

0

5

Рис. 2.2.

В состав ППП Neural Network Toolbox входит М-функция hardlim, реализующая

функцию активации с жесткими ограничениями. Теперь можно построить график этой

функции, применяя операторы языка MATLAB:

n = –5:0.1:5;

plot(n,hardlim(n),'c+:');

В результате получим график функции hardlim в диапазоне значений входа от –5 до + 5

(рис. 2.2).

Линейная функция активации purelin. Эта функция описывается соотношением

a = purelin(n) = n и показана на рис. 2.3.

Рис. 2.3.

Логистическая функция активации logsig. Эта функция описывается соотношением

a = logsig(n) = 1/(1 + exp(–n)) и показана на рис. 2.4. Она принадлежит к классу

сигмоидальных функций, и ее аргумент может принимать любое значение в диапазоне от

Сигмоидальной (S-образной) функцией называется непрерывная функция, имеющая две

горизонтальные асимптоты и одну точку перегиба.

1

34

Нейронные сети. MATLAB 6

– до +, а выход изменяется в диапазоне от 0 до 1. В ППП Neural Network Toolbox она

представлена М-функцией logsig. Благодаря свойству дифференцируемости эта функция

часто используется в сетях с обучением на основе метода обратного распространения ошибки.

Рис. 2.4.

Символ в квадрате в правом верхнем углу графика характеризует функцию

активации. Это изображение используется на структурных схемах нейронных сетей.

В ППП Neural Network Toolbox включены и другие функции активации. Используя

язык MATLAB, пользователь может создавать и свои собственные уникальные функции.

2.1.3. Нейрон с векторным входом

Нейрон с одним вектором входа p с R элементами p1, p2, …, pR показан на рис. 2.5.

Здесь каждый элемент входа умножается на веса w11, w12, … , w1R соответственно и

взвешенные значения передаются на сумматор. Их сумма равна скалярному

произведению вектора – строки W на вектор входа p.

Рис. 2.5

Нейрон имеет смещение b, которое суммируется со взвешенной суммой входов.

Результирующая сумма n равна

n = w11 p1 + w12 p2 + … + w1R pR + b

(2.3)

и служит аргументом функции активации f. В нотации языка MATLAB это выражение

записывается так:

2. Модель нейрона и архитектура сети

35

n = W*p + b.

(2.4)

Структура нейрона, показанная выше, содержит много лишних деталей. При

рассмотрении сетей, состоящих из большого числа нейронов, будет использоваться

укрупненная структурная схема нейрона (рис. 2.6).

Рис. 2.6

Вход нейрона изображается в виде темной вертикальной черты, под которой

указывается количество элементов входа R. Размер вектора входа p указывается ниже

символа

p

и равен R1. Вектор входа умножается на вектор-строку W длины R. Как и прежде,

константа 1 рассматривается как вход, который умножается на скалярное смещение b.

Входом n функции активации нейрона служит сумма смещения b и произведения W*p.

Эта сумма преобразуется функцией активации f, на выходе которой получаем выход

нейрона a, который в данном случае является скалярной величиной. Структурная схема,

приведенная на рис. 2.6, называется слоем сети. Слой характеризуется матрицей весов

W, смещением b, операциями умножения W*p, суммирования и функцией активации f.

Вектор входов p обычно не включается в характеристики слоя.

Каждый раз, когда используется сокращенное обозначение сети, размерность матриц

указывается под именами векторно-матричных переменных. Эта система обозначений

поясняет строение сети и связанную с ней матричную математику.

На укрупненной структурной схеме для обозначения типа функции активации

применяются специальные графические символы; некоторые из них приведены на

рис. 2.7, где. а – ступенчатая, б – линейная, в – логистическая функция.

hardlim

а

purelin

б

Рис. 2.7

logsig

в

2.2. Архитектура нейронных сетей

Реальная нейронная сеть может содержать один или большее количество слоев

и соответственно характеризоваться как однослойная или как многослойная.

36

Нейронные сети. MATLAB 6

2.2.1. Однослойные сети

Развернутая схема сети из одного слоя с R входными элементами и S нейронами

показана на рис. 2.8.

Рис. 2.8

В этой сети каждый элемент вектора входа соединен со всеми входами нейрона и это

соединение задается матрицей весов W; при этом каждый i-й нейрон включает

суммирующий элемент, который формирует скалярный выход n(i). Совокупность

скалярных функций n(i) объединяется в S-элементный вектор входа n функции активации

слоя.

Выходы слоя нейронов формируют вектор-столбец a, и, таким образом, описание слоя

нейронов имеет вид:

a f(W * p b) .

(2.5)

Количество входов R в слое может не совпадать с количеством нейронов S. В каждом

слое, как правило, используется одна и та же функция активации. Однако можно

создавать составные слои нейронов с использованием различных функций активации,

соединяя сети, подобные изображенной на рис. 2.8, параллельно. Обе сети будут иметь те

же самые входы, и каждая сеть будет генерировать определенную часть выходов.

Элементы вектора входа передаются в сеть через матрицу весов W, имеющую вид:

w11

w

W 21

wS1

w12

w22

wS 2

w1R

w2 R

.

wSR

(2.6)

Заметим, что индексы строк матрицы W указывают адресатов (пункты назначения)

весов нейронов, а индексы столбцов – какой источник является входом для этого веса.

2. Модель нейрона и архитектура сети

37

Таким образом, элемент матрицы весов w12 = W(1, 2) определяет коэффициент, на

который умножается второй элемент входа при передаче его на первый нейрон.

Для однослойной сети с S нейронами укрупненная структурная схема показана

на рис. 2.9.

Рис. 2.9

Здесь p – вектор входа размера R×1, W – весовая матрица размера S×R, a, b, n –

векторы размера S×1.

2.2.2. Многослойные сети

Рассмотрим сети, имеющие несколько слоев. Будем называть весовые матрицы,

соединенные с входами, весами входа слоя, а весовые матрицы для сигналов, исходящие

из слоя, назовем весами выхода слоя. Далее, будем использовать верхние индексы, чтобы

указать источник и адресат для различных весов и других элементов нейронной сети.

Чтобы пояснить это, рассмотрим сначала только один, первый слой многослойной сети

(рис. 2.10).

Рис. 2.10

Обозначим весовую матрицу, связанную с входами, через IW11, верхние индексы

которой указывают, что источником входов является первый слой (второй индекс) и

адресатом является также первый слой (первый индекс). Элементы этого слоя, такие, как

смещение b1, вход функции активации n1 и выход слоя a1, имеют верхний индекс 1, чтобы

обозначить, что они связаны с первым слоем. В дальнейшем для матриц весов входа

и выхода слоя будут использованы обозначения IW(Input Weight) и LW(Layer Weight)

соответственно.

38

Нейронные сети. MATLAB 6

Когда сеть имеет несколько слоев, то каждый слой имеет свою матрицу весов W,

вектор смещения b и вектор выхода a. Чтобы различать весовые матрицы, векторы

выхода

и т. д. для каждого из этих слоев, введем номер слоя как верхний индекс для

представляющей интерес переменной. Использование этой системы обозначений для сети

из трех слоев можно видеть на показанной ниже структурной схеме и из уравнений,

приведенных в нижней части рис. 2.11.

Рис. 2.11

Сеть, показанная выше, имеет R входов, S нейронов в первом слое, S нейронов во

втором слое и т. д. Для общности будем считать, что различные слои имеют различное

число нейронов. На смещения для каждого нейрона подан постоянный входной сигнал 1.

Заметим, что выходы каждого промежуточного слоя служат входами для следующего

слоя. Таким образом, слой 2 может быть рассмотрен как один слой сети с S1 входами, S2

нейронами и S1 S2 матрицей весов W2. Вход к слою 2 есть 1, а выход - 2. Теперь, когда

обозначены все векторы и матрицы слоя 2, можно трактовать его как самостоятельную

однослойную сеть. Такой подход может быть использован к любому слою сети.

Слои многослойной сети имеют различные назначения. Слой, который образует

выход сети, называется слоем выхода. Все другие слои называются скрытыми слоями.

Трехслойная сеть, показанная выше, имеет выходной слой (слой 3) и 2 скрытых слоя

(слой 1 и слой 2). Эта же трехслойная сеть может быть представлена в виде укрупненной

структурной схемы (рис. 2.12).

1

2. Модель нейрона и архитектура сети

2

39

Рис. 2.12

Заметим, что выход третьего слоя а3 обозначен через y. Эта сделано для того, чтобы

подчеркнуть, что выход последнего слоя является выходом сети.

Многослойные сети обладают весьма мощными возможностями. Например,

двухслойная сеть, в которой первый слой содержит сигмоидальную, а второй слой –

линейную функцию активации, может быть обучена аппроксимировать с произвольной

точностью любую функцию с конечным числом точек разрыва.

В заключение можно сформулировать следующие выводы. Вход функции активации

нейрона определяется смещением и суммой взвешенных входов. Выход нейрона зависит

как от входов нейрона, так и от вида функции активации. Один нейрон не может решать

сложные задачи, однако несколько нейронов, объединенных в один или несколько слоев,

обладают большими возможностями.

Архитектура сети состоит из описания того, сколько слоев имеет сеть, количества

нейронов в каждом слое, вида функции активации каждого слоя и информации о соединении

слоев. Архитектура сети зависит от той конкретной задачи, которую должна решать сеть.

Работа сети состоит в вычислении выходов сети на основе известных входов с целью

формирования желаемого отображения вход/выход. Конкретная задача определяет число

входов и число выходов сети. Кроме числа нейронов в выходном слое сети, для

проектировщика важно число нейронов в каждом слое. Большее количество нейронов в

скрытых слоях обеспечивает более мощную сеть. Если должно быть реализовано

линейное

отображение, то следует использовать нейроны с линейными функциями активации.

При этом надо помнить, что линейные нейронные сети не могут формировать нелинейные

отображения. Использование нелинейных функций активации позволяет настроить

нейронную сеть на реализацию нелинейных связей между входом и выходом.

Сети со смещением позволяют формировать более сложные связи между входами

и выходами, чем сети без смещения. Например, нейрон без смещения, когда все входы

нулевые, будет всегда задавать вход функции активации равным нулю, однако нейрон

со смещением может быть обучен так, чтобы при тех же условиях задать вход функции

активации произвольной формы.

В многослойных сетях часто применяются нелинейные сигмоидальные функции

активации типа логистической (см. рис. 2.7, в) или гиперболического тангенса (рис. 2.13).

a

+1

0

n

-1

a = tansig(n)

Рис. 2.13

Если последний слой многослойной сети использует такие функции активации, то

выходы сети будут ограничены. Когда в выходном слое используются линейные нейроны, то

выходы сети могут принимать произвольные значения. В ППП NNT предусмотрены

40

Нейронные сети. MATLAB 6

М-функции, позволяющие вычислять производные функций активации. Чтобы получить

информацию об имени нужной функции, следует воспользоваться следующим оператором:

<имя_функции_активации>('deriv')

Например, обращение вида

tansig('deriv')

ans = dtansig

дает возможность узнать, что имя М-функции, позволяющей вычислить производную

гиперболического тангенса, dtansig.

2.2.3. Сети с прямой передачей сигнала

Однослойная сеть с S нейронами с функциями активации logsig, имеющая R входов,

показана на рис. 2.14.

Входы

Слой нейронов

n1

p1

p2

Слой нейронов

Вход

a1

p

W

a

n

1R

SR

n2

p3

b

a2

R

pR

S1

S

S1

a = f(Wp+b)

b2

1

S1

1

b1

1

nS

aS

1

bS

a = f(Wp+b)

Рис. 2.14

Эта сеть, не имеющая обратных связей, называется сетью с прямой передачей сигнала.

Такие сети часто имеют один или более скрытых слоев нейронов с сигмоидальными

функциями активации, в то время как выходной слой содержит нейроны с линейными

функциями активации. Сети с такой архитектурой могут воспроизводить весьма сложные

нелинейные зависимости между входом и выходом сети.

Для пояснения обозначений в многослойных нейронных сетях внимательно изучите

двухслойную сеть, показанную на рис. 2.15

2. Модель нейрона и архитектура сети

41

Вход

Выходной слой

Скрытый слой

p1

IW

21

1

2

11

a1

n1

LW21

41

42

1

b

1

41

41

34

b2

31

31

4

a1= tansig(IW11 p1 + b1)

a2

n2

3

31

a2= purelin(LW21 a1 + b2)

Рис. 2.15

Эта сеть может быть использована для аппроксимации функций. Она может

достаточно точно воспроизвести любую функцию с конечным числом точек разрыва, если

задать достаточное число нейронов скрытого слоя.

2.3. Создание, инициализация и моделирование сети

Формирование архитектуры сети

Первый шаг при работе с нейронными сетями – это создание модели сети. Для

создания сетей с прямой передачей сигнала в ППП NNT предназначена функция newff.

Она имеет 4 входных аргумента и 1 выходной аргумент – объект класса network. Первый

входной аргумент – это массив размера R2, содержащий допустимые границы значений

(минимальное и максимальное) для каждого из R элементов вектора входа; второй –

массив для задания количества нейронов каждого слоя; третий – массив ячеек,

содержащий имена функций активации для каждого слоя; четвертый – имя функции

обучения.

Например, следующий оператор создает сеть с прямой передачей сигнала:

net = newff([–1 2; 0 5],[3,1],{'tansig','purelin'},'traingd');

Эта сеть использует 1 вектор входа с двумя элементами, имеющими допустимые

границы значений [–1 2] и [0 5]; имеет 2 слоя с тремя нейронами в первом слое и одним

нейроном во втором слое; используемые функции активации: tansig – в первом слое,

purelin – во втором слое; используемая функция обучения – traingd.

М-функция newff не только создает архитектуру сети, но и инициализирует ее веса

и смещения, подготавливая нейронную сеть к обучению. Однако существуют ситуации,

когда требуется специальная процедура инициализации сети.

Инициализация сети

После того как сформирована архитектура сети, должны быть заданы начальные

значения весов и смещений, или, иными словами, сеть должна быть инициализирована.

Такая процедура выполняется с помощью метода init для объектов класса network.

Оператор вызова этого метода имеет вид:

net = init(net);

42

Нейронные сети. MATLAB 6

Способ инициализации зависит от выбора параметров сети net.initFcn и net.layers{i}.initFcn,

которые устанавливают ту или иную функцию инициализации. Параметр net.initFcn

задает функцию инициализации для всей сети. Для сетей с прямой передачей сигнала по

умолчанию используется функция инициализации initlay, которая разрешает для каждого

слоя сети использовать собственную функцию инициализации, определяемую свойством

net.layers{i}.initFcn.

Для сетей с прямой передачей сигнала обычно применяется одна из двух функций

инициализации слоя: initwb или initnw.

Функция initwb позволяет использовать собственные функции инициализации для каждой

матрицы весов входа и вектора смещений, задавая параметры net.inputWeights{i, j}.initFcn

и net.biases{i}.initFcn. Для сетей без обратных связей с линейными функциями активации

веса обычно инициализируются случайными значениями из интервала [–1 1].

Функция initnw применяется для слоев, использующих сигмоидальные функции

активации. Она генерирует начальные веса и смещения для слоя так, чтобы активные

области нейронов были распределены равномерно относительно области значений входа.

Это имеет несколько преимуществ по сравнению со случайным распределением весов и

смещений: во-первых, избыток нейронов минимален, поскольку активные области всех

нейронов соответствуют области значений входа, во-вторых, обучение выполняется

быстрее, так как для каждой области значений входа найдутся нейроны с той же областью

определения аргумента.

В рассмотренном выше примере создания сети с прямой передачей сигнала метод init

вызывается автоматически при обращении к М-функции newff. Поэтому инициализация

сети выполняется по умолчанию. Если же пользователь хочет применить специальный

метод инициализации или принудительно установить значения весов и смещений, то он

может непосредственно обратиться к функции init.

Например, если мы хотим заново инициализировать веса и смещения в первом слое,

используя функцию rands, то надо ввести следующую последовательность операторов:

net.layers{1}.initFcn = 'initwb';

net.inputWeights{1,1}.initFcn = 'rands';

net.biases{1,1}.initFcn = 'rands';

net.biases{2,1}.initFcn = 'rands';

net = init(net);

Моделирование сети

Статические сети. Статическая нейронная сеть характеризуется тем, что в ее составе

нет элементов запаздывания и обратных связей. Ее поведение не зависит от типа вектора

входа, поскольку последовательно подаваемые векторы можно рассматривать как

действующие одновременно или как один объединенный вектор. Поэтому в качестве

модели статической сети рассмотрим сеть, показанную на рис. 2.16.

2. Модель нейрона и архитектура сети

43

Рис. 2.16

Это однослойная сеть с двухэлементным вектором входа и линейной функцией

активации. Для задания такой сети предназначена М-функция newlin из ППП Neural Network Toolbox, которая требует указать минимальное и максимальное значение для

каждого

из элементов входа; в данном случае они равны –1 и 1 соответственно, а также количество

слоев, в данном случае 1.

% Формирование однослойной линейной сети net с двухэлементным

% входным сигналом со значениями от –1 до 1

net = newlin([–1 1;–1 1],1);

Определим весовую матрицу и смещение равными W = [1 2], b = 0, и зададим эти

значения, используя описание структуры сети

net.IW{1,1} = [1 2]; % Присваивание значений весов

net.b{1} = 0; % Присваивание значения смещения

Предположим, что на сеть подается такая последовательность из четырех векторов

входа:

1

,

0

0 0 1

1 , 1 , 1 .

(2.7)

Поскольку сеть статическая, можно перегруппировать эту последовательность в

следующий числовой массив:

P = [–1 0 0 1; 0 –1 1 –1];

Теперь можно моделировать сеть:

A = sim(net,P) % Моделирование сети net с вектором входа P и выходом A

A = –1 –2 2 –1

Результат нужно интерпретировать следующим образом. На вход сети подается

последовательность из четырех входных сигналов, и сеть генерирует вектор выхода

из четырех элементов. Результат был тот же самый, если бы имелось 4 одинаковых сети,

функционирующих параллельно, и на каждую сеть был подан один из векторов входа

и генерировался один из выходов.

Динамические сети. Когда сеть содержит линии задержки, вход сети надо рассматривать

как последовательность векторов, подаваемых на сеть в определенные моменты времени.

44

Нейронные сети. MATLAB 6

Чтобы пояснить этот случай, рассмотрим простую линейную сеть, которая содержит 1

элемент линии задержки (рис. 2.17).

Рис. 2.17

Построим такую сеть:

% Создание однослойной линейной сети с линией задержки [0 1]

net = newlin([–1 1],1,[0 1]);

Зададим следующую матрицу весов W = [1 2] и нулевое смещение:

net.IW{1,1} = [1 2]; % Присваивание значений весов

net.biasConnect = 0; % Присваивание значений смещений

Предположим, что входная последовательность имеет вид {–1, –1/2, 1/2, 1}, и зададим

ее в виде массива ячеек

P = {–1 –1/2 1/2 1};

Теперь можно моделировать сеть, используя метод sim:

A = sim(net,P) % Моделирование сети net с входным сигналом P и выходом A

A = [–1] [–5/2] [–1/2] [2]

Действительно,

1

1 / 2

1/ 2

1

1 1 2 1 5 / 2 1 2 1 / 2 1 / 2 1 2 1 / 2 2 .

0

1 2

(2.8)

Введя массив ячеек, содержащий последовательность входов, сеть сгенерировала

массив ячеек, содержащий последовательность выходов. В данном случае каждый выход

формируется согласно соотношению

a(t) = p(t) + 2p(t–1).

(2.9)

При изменении порядка следования элементов во входной последовательности будут

изменяться значения на выходе.

Если те же самые входы подать на сеть одновременно, то получим совершенно иную

реакцию. Для этого сформируем следующий вектор входа:

P = [–1 –1/2 1/2 1];

После моделирования получаем:

A = sim(net,P) % Моделирование сети

A = –1 –1/2 1/2 1

2. Модель нейрона и архитектура сети

45

Результат такой же, как если применить каждый вход к отдельной сети и вычислить

ее выход. Поскольку начальные условия для элементов запаздывания не указаны, то по

умолчанию они приняты нулевыми. В этом случае выход сети равен

1 1 / 2 1 / 2

[1 2]

0

0

0

1

1 1 / 2 1 / 2 1 .

0

(2.10)

Если требуется моделировать реакцию сети для нескольких последовательностей

сигналов на входе, то надо сформировать массив ячеек, размер каждой из которых

совпадает с числом таких последовательностей. Пусть, например, требуется приложить к

сети 2 последовательности:

p1 (1) [1] , p1 (2) [1 / 2] , p1 (3) [1 / 2] ,

p1 (4) [1] ;

p 2 (1) [1] , p 2 (2) [1 / 2] , p 2 (3) [1 / 2] , p 2 (4) [1] .

(2.11)

Вход P в этом случае должен быть массивом ячеек, каждая из которых содержит два

элемента по числу последовательностей

P = {[–1 1] [–1/2 1/2] [1/2 –1/2] [1 –1]};

Теперь можно моделировать сеть:

A = sim(net,P); % Моделирование сети net с входным сигналом P и выходом A

Результирующий выход сети равен

A = {[–1 1] [–5/2 5/2] [–1/2 1/2] [2 –2]}

В самом деле,

1 1

{ 1 2

,

0 0 1 1

1 / 2 1 / 2

1 2

1 / 2 1 / 2 ,

1 / 2 1 / 2

1 / 2 1 / 2

5 / 2 5 / 2 ,

1

1

1 2

1

1

2 2 }

1 / 2 1 / 2

1 2

На рис. 2.18 показан формат массива P, представленного Q выборками (реализациями),

при моделировании сети.

Q-я выборка

{[p1(1), p2(1), …, pQ(1)], [p1(2), p2(2), … , pQ(2)], …, [p1(TS), p2(TS), …, pQ(TS)]}

Первая выборка

Рис. 2.18

В данном случае это массив ячеек с одной строкой, каждый элемент которой

объединяет Q реализаций вектора p – [p1(TS), p2(TS), …, pQ(TS)] – для некоторого момента

времени TS. Если на вход сети подается несколько векторов входа, то каждому входу

будет соответствовать 1 строка массива ячеек. Представление входов как массива ячеек

соответствует последовательному представлению наблюдаемых данных во времени.

46

Нейронные сети. MATLAB 6

Представление вектора входа может быть интерпретировано иначе, если

сформировать временные последовательности для каждой реализации, как это показано

на рис. 2.18. Тогда можно говорить о том, что на вход сети подается Q выборок из

интервала времени [1, TS], которые могут быть описаны числовым массивом P вида

P = [[p1(1), p1(2), …, p1(TS)]; [p2(1), p2(2), …, p2(TS)]; …

…; [pQ(1), pQ(2), …, pQ(TS)]].

(2.12)

Представление входов как числового массива выборок в формате double

соответствует групповому представлению данных, когда реализации вектора входа для

всех значений времени на интервале выборки обрабатываются потоком.

2. Модель нейрона и архитектура сети

47

3. ОБУЧЕНИЕ НЕЙРОННЫХ СЕТЕЙ

При решении с помощью нейронных сетей прикладных задач необходимо собрать

достаточный и представительный объем данных для того, чтобы обучить нейронную сеть

решению таких задач. Обучающий набор данных – это набор наблюдений, содержащих

признаки изучаемого объекта. Первый вопрос, какие признаки использовать и сколько

и какие наблюдения надо провести.

Выбор признаков, по крайней мере первоначальный, осуществляется эвристически на

основе имеющегося опыта, который может подсказать, какие признаки являются наиболее

важными. Сначала следует включить все признаки, которые, по мнению аналитиков или

экспертов, являются существенными, на последующих этапах это множество будет

сокращено.

Нейронные сети работают с числовыми данными, взятыми, как правило, из

некоторого ограниченного диапазона. Это может создать проблемы, если значения

наблюдений выходят за пределы этого диапазона или пропущены.

Вопрос о том, сколько нужно иметь наблюдений для обучения сети, часто

оказывается непростым. Известен ряд эвристических правил, которые устанавливают

связь между количеством необходимых наблюдений и размерами сети. Простейшее из

них гласит, что количество наблюдений должно быть в 10 раз больше числа связей в сети.

На самом деле это число зависит от сложности того отображения, которое должна

воспроизводить нейронная сеть. С ростом числа используемых признаков количество

наблюдений возрастает по нелинейному закону, так что уже при довольно небольшом

числе признаков, скажем 50, может потребоваться огромное число наблюдений. Эта

проблема носит название "проклятие размерности".

Для большинства реальных задач бывает достаточным нескольких сотен или тысяч

наблюдений. Для сложных задач может потребоваться большее количество, однако очень

редко встречаются задачи, где требуется менее 100 наблюдений. Если данных мало, то

сеть не имеет достаточной информации для обучения, и лучшее, что можно в этом случае

сделать, – это попробовать подогнать к данным некоторую линейную модель.

3.1. Процедуры адаптации и обучения

После того как определено количество слоев сети и число нейронов в каждом из них,